La face cachée de l’IA

Sommaire :

24heures du 22 décembre 2023

Éditorial

Des mines congolaises aux cybercafés philippins, une armée de travailleurs pauvres sous-tendent le progrès technologique. Le monde de demain menace de ressembler à celui d’hier.

Dans un futur de moins en moins lointain, nous roulerons tous en voiture électrique et utiliserons l’intelligence artificielle des dizaines de fois par jour, souvent sans même nous en rendre compte. Nos taxis seront autonomes, nos épiceries devanceront nos besoins et, qui sait, nous pourrions même décoller à bord d’avions «verts».

La dématérialisation induite par l’avènement d’internet peut nous faire penser que ces innovations sont, elles aussi, enfantées dans les limbes du web. Bien au contraire, elles sont puissamment ancrées dans le monde physique: les batteries électriques requièrent de gigantesques quantités de minerais et des milliards de mégawattheures. L’IA nécessite une puissance de calcul pharaonique et des millions de semi-conducteurs dernier cri.

Cette révolution technologique repose par ailleurs sur une armée de travailleurs pauvres dont nous ignorons l’existence. Dans les mines africaines, ils sont des milliers à extraire le cobalt à mains nues pour alimenter nos batteries. Dans les cybercafés de Manille ou de Lagos, une myriade de jeunes informaticiens sont exploités pour entraîner les algorithmes des entreprises championnes de l’IA installées dans la Silicon Valley.

Nuit et jour, pour une bouchée de pain et sans la moindre protection sociale, ces esclaves des temps modernes abattent sur leurs écrans les millions de microtâches nécessaires à l’avènement du monde de demain. Une «ubérisation» poussée à l’extrême, par-delà les frontières, démontrant au passage que le télétravail peut parfois se transformer en outil d’asservissement.

Les technologies sont nouvelles, mais certaines de leurs recettes de fabrication sont tristement éculées. Le progrès ne saurait être seulement technique. Il doit aussi être social.

* (NDComp - Nous savons, par expérience, ce qui se cache dernière ces injonctions et ces vœux pieux – des exigences impossibles à concrétiser car il y a trop d’intérêts en jeu et trop à perdre pour la classe dirigeante qui d’aucune façon voudront créer des lois dites "sociales" censées défendre nos places de travail ou de nous assurer une protection valable. D’autant plus que la majorité politique est quand même largement à droite. La dématérialisation induite par l’avènement d’internet et ses innovations est devenue une réalité incontournable de laquelle nous ne pouvons nous échapper...)

Liens

Mines en République démocratique du Congo Un pillage Le Monde - Afrique

Progrès technique permet une hausse de productivité - Dictionnaire historique - Thomas Perret

Moratoire surdash; l’IA arrêtons plutot le techno-bullshit pour toujours Heidi.News

recettes de fabrication tristement éculées Des engrenages à la chaîne - Presses universitaires de Lyon

Remotasks bull-shit jobs dernière l’ecran

24heures du 22 décembre 2023

L’envers du développement de l’IA

Des dizaines de milliers d’informaticiens philippins entraînent les algorithmes des leaders mondiaux de l’intelligence artificielle. Souvent dans une grande précarité.

Théophile Simon - à Cagayan de Oro (Philippines)

Dans la pénombre de sa petite chambre aux murs de tôle, les yeux rivés sur un vieil écran d’ordinateur, Cheiro, 27 ans, manipule avec son clavier un nuage de milliers de points disséminés sur un plan en trois dimensions. Juxtaposant l’ensemble avec une photo prise depuis le tableau de bord d’une voiture roulant à San Francisco, il sélectionne certains agglomérats de points à l’aide de sa souris puis note leurs coordonnées géométriques dans un logiciel.

«Chacun de ces points matérialise le rebond du laser projeté par la voiture autonome au moment où elle analyse son environnement. «Je dois identifier chaque forme afin d’aider le véhicule à distinguer une autre voiture d’un piéton, un arbre d’un panneau ou un animal d’un bâtiment. Je répète cette tâche environ douze heures par jour, sept jours par semaine, souvent la nuit», soupire-t-il en pointant vers un coin de la pièce, où une paillasse malodorante gît sur une palette de bois. «Si je comprends bien, ces données permettront un jour à l’intelligence artificielle de remplacer les conducteurs.»

Par la fenêtre, le clair de lune éclabousse ce bidonville de Cagayan de Oro, une grande ville du sud des Philippines. Des dizaines d’habitants du quartier effectuent des tâches similaires. Installés dans un cybercafé faute d’ordinateur personnel, Junbee et John-Henry, deux garçons d’une vingtaine d’années, planchent sur des photos de nourriture. «On découpe le contour de chaque aliment avant de l’identifier dans le logiciel. En répétant cette tâche des milliers de fois, on apprend à la machine à reconnaître toute seule les objets. Cette technologie est déjà intégrée aux nouveaux iPhone», explique John-Henry en cliquant sur une photo d’œufs durs posés à côté de barres de céréales.

( * NDComp - Rien qu’avec cette description, on peut constater qu’en fait le "machine-learning" sert surtout pour apprendre aux machines à faire notre "job" pour une meilleure productivité, pour mieux faire des profits en éliminant le facteur humain et ses défauts...)

Ruée vers la donnée

Un logo vert situé à gauche de leur écran trahit l’identité de leur employeur: Remotasks, une filiale de la start-up américaine ScaleAI. Fondée en 2016 à San Francisco par Alexandr Wang, un petit génie du MIT alors âgé d’à peine 19 ans, l’entreprise se spécialise dans la fourniture de données aux leaders mondiaux de l’IA. Un filon juteux: lors de sa dernière levée de fonds, en 2021, ScaleAI a été valorisée à 7,3 milliards de dollars. L’entreprise compte parmi ses clients Apple, Google, OpenAI, Samsung, Amazon ou encore l’armée américaine.

Afin d’entraîner leurs algorithmes, champions de la Silicon Valley, constructeurs automobiles et autres multinationales appâtées par les promesses de l’IA nécessitent d’immenses quantités de données «annotées», c’est-à-dire préalablement déchiffrées et organisées par des humains. Les textes ingurgités par ChatGPT doivent être nettoyés de tout propos raciste ou sexiste; le contenu des millions d’heures de vidéos filmées par les voitures autonomes de Google doit être soigneusement identifié; l’océan de photos captées par les téléphones portables d’Apple ou Samsung doit être épluché.

Armée de sous-traitants

Pour effectuer ces milliards de microtâches, Remotasks a tissé un réseau d’environ 240'000 collaborateurs dans plusieurs pays du Sud, dont une bonne partie aux Philippines, où l’entreprise a débarqué en 2017. Tous sont réunis sur une plateforme en ligne permettant de dispatcher les données à annoter aux quatre coins de la planète. Chacun de ces «taskers» – surnom donné par Remotasks – est rémunéré quelques centimes par tâche et voit son pécule versé via PayPal. Aucun de ces sous-traitants n’est formellement salarié par l’entreprise californienne, qui peut ainsi s’affranchir des législations nationales.

«Je travaille sur Remotasks sept jours sur sept depuis près de quatre ans, cela me rapporte environ 8 dollars par jour pour dix à douze heures de travail quotidien. C’est moins que le minimum légal et je n’ai aucune protection sociale, mais je n’ai pas le choix. Dans ce coin des Philippines, il y a très peu d’emplois», explique Cheiro. «L’autre solution, c’est de vendre de la drogue. Or je veux un avenir», ajoute John-Henry, dont l’un des parents vient d’écoper de plusieurs années de prison pour trafic de stupéfiants. Selon le directeur de l’Université de Cagayan de Oro, le marché du travail local ne peut absorber qu’un quart d’une classe d’âge.

«C’est de l’exploitation»

Profitant de cette main-d’œuvre bon marché et désœuvrée, Remotasks a monté à Cagayan de Oro une impressionnante logistique. Tout un immeuble du centre-ville a été loué en 2020 avant d’être rempli de centaines de postes de travail. Nuit et jour, suivant les trois-huit, des cohortes de jeunes défilent pour être formées à l’annotation de données par des cadres de l’entreprise. Au bout de quelques mois, ils sont renvoyés chez eux pour travailler en ligne.

«Au moins 10'000 personnes ont été formées rien qu’à Cagayan de Oro, qui constitue la tête de pont de Remotasks aux Philippines. Sur le papier, ces gens sont des sous-traitants indépendants. Mais ils ont un supérieur hiérarchique, des horaires de bureau et même des créneaux pour la pause déjeuner. C’est de l’exploitation pure et simple», témoigne un ancien cadre de Remotasks dans le pays, qui a lui-même formé des milliers de ces forçats de l’IA.

Interrogé sur les pratiques de Remotasks, le responsable local de l’inspection du travail suspecte un recours massif à du travail dissimulé et promet d’ouvrir une enquête. «Cela sera cependant difficile. Nous n’avons guère de pouvoir sur une entreprise étrangère et le travail en ligne complique encore plus les contrôles», prévient-il. En cas de problème, Remotasks ne manquera pas d’alternatives: l’entreprise a récemment ouvert des bureaux au Nigeria et au Venezuela, où la main-d’œuvre est encore moins chère. Le marché de l’annotation de données devrait, lui, être multiplié par dix d’ici à la fin de la décennie pour s’approcher des 9 milliards de dollars.

«Ces données permettront un jour à l’intelligence artificielle de remplacer les conducteurs.»

«L’autre solution, c’est de vendre de la drogue. Or je veux un avenir.»

«Au moins 10'000 personnes ont été formées rien qu’à Cagayan de Oro. C’est de l’exploitation pure et simple.»

* * * *

Publié: 24heures du 21.11.2023, 10h02

Monde du travail

Utiliser des algorithmes pour trier des CV ou augmenter la productivité fait débat. Des voix s’élèvent pour une meilleure protection des employés.

Delphine Gasche - Berne

Un algorithme qui zappe les conditions météorologiques. Un autre qui évalue les employés de manière opaque. L’utilisation toujours plus fréquente de l’intelligence artificielle dans le monde du travail pose parfois problème. Un avis de droit, publié ce dimanche par deux chercheuses de l’Université de Saint-Gall après quatre ans de travail, dénonce des lacunes.

Pas de consultation ni de transparence

Prenons un exemple concret. Une boîte de livreurs suisse a fait appel à un algorithme pour planifier au mieux les routes de ses livreurs. Problème: le système était mal configuré.

«Il ne prenait pas en compte la neige ou les routes de montagne, qui nécessitent de rouler à vitesse réduite. Les chauffeurs étaient alors systématiquement mal notés», rapporte Isabel Ebert, co-autrice de l’avis de droit. Avec comme corollaire du stress, de la fatigue, des heures sup, voire de potentielles amendes ou accidents si les chauffeurs tentent de rattraper leur retard en dépassant les limites autorisées.

Outre le cas du transporteur, la spécialiste en questions éthiques a noté que de tels systèmes étaient souvent introduits sans la consultation des employés et manquaient de transparence.

Imaginons maintenant un processus de recrutement. Cent personnes postulent pour un poste. Une première sélection est réalisée par un algorithme. Une femme d’origine étrangère de 57 ans aura toutes les peines du monde à savoir pourquoi son dossier n’a pas atterri sur le bureau des ressources humaines. Ses qualifications sont-elles vraiment insuffisantes? Ou le système est-il raciste ou misogyne? Ou alors son âge a-t-il été considéré trop élevé ?

Barbara Gysi (PS/SG) veut porter le combat à Berne et Samuel Bendahan (PS/VD) dénonce un vide juridique à combler.

Face à ces constats, Syndicom et AlgorithmWatch CH montent au créneau. Ils revendiquent une meilleure information et inclusion du personnel lors de l’introduction de systèmes basés sur l’IA, mais aussi la possibilité d’instaurer des sanctions.

«Ne pas respecter la loi n’a actuellement pas de conséquences. Il n’y a aucun incitatif», dénonce Bettina Dürr, en charge du dossier chez AlgorithmWatch CH. Envisage-t-elle des amendes? «Ce n’est pas forcément la meilleure solution. Si ne pas suivre la loi est plus profitable, les amendes ne servent à rien. On le voit dans d’autres domaines comme la protection des données, les grandes entreprises peuvent tout simplement les prendre en compte dans leur budget.»

Les deux organisations ont obtenu un relais sous la Coupole. Barbara Gysi (PS/SG) entend déposer une motion à la session d’hiver. La proposition demande une plus grande transparence, une meilleure consultation et implication du personnel lors de l’introduction de nouveaux outils basés sur l’intelligence artificielle. Des sanctions et la possibilité de mener des actions collectives doivent aussi être envisagées.

«Quand les conditions de travail changent drastiquement, les employés doivent être inclus dans les discussions, estime la Saint-Galloise. Avec la digitalisation et le home office, par exemple, les possibilités de surveillance sont beaucoup plus grandes. Le personnel doit être mieux protégé.»

Filmer ses employés n’est pas autorisé, rappelle Samuel Bendahan (PS/VD), qui soutiendra sa collègue de parti. En revanche, il est possible de récolter des données sur la durée de connexion d’une personne sur son ordinateur, le nombre de dossiers traités, le respect des délais, etc. «Plus l’employeur détient de données, plus c’est dangereux pour un employé. Car s’il veut le renvoyer, il trouvera une raison parmi la quantité d’informations à sa disposition.»

La situation n’est pas encore dramatique, reconnaît le Vaudois. Elle peut toutefois vite dégénérer. «Toutes les entreprises ne font pas appel à l’intelligence artificielle. Et il y a encore peu de cas problématiques. Mais la technologie existe. C’est désormais possible de donner à ChatGPT un fichier Excel avec un certain nombre de données et lui demander une liste des personnes à licencier selon certains critères.»

Les algorithmes en eux-mêmes ne posent pas forcément problème. «Mais il y a un certain vide juridique», note-t-il. Pour les deux conseillers nationaux, il faut adapter la loi. Un changement d’ordonnance serait insuffisant. Ils ont encore du pain sur la planche. Pas sûr que leurs collègues bourgeois, plutôt favorables aux nouvelles technologies, les suivent sur ce coup.

(NDComp - Encore des injonctions et des vœux pieux improbables et idéalistes car il y a trop d’intérêts cachés et la classe dirigeante ayant trop à perdre ne voudra d’aucune façon créer des lois dites "sociales" censées défendre nos places de travail ou de nous assurer une protection valable. D’autant plus que de l’exigence de l’adaptation met sur notre dos la seule responsabilité de notre survivance. Effectivement la majorité politique étant quand même largement à droite, il n’est pas possible de compter sur elle pour fabriquer des lois dites "justes". L’avènement de l’internet et ses innovations est devenue une réalité incontournable à laquelle nous ne pourrons nous échapper...)

Liens

Human Trafficking - Hub: Cagayan de Oro

AlgorithmWatch - organisation de défense des droits humains à Zurich et à Berlin

Les questions les plus fréquentes - sur les dangers de l’intelligence artificielle

Plus besoin de se casser la tête, ChatGPT vous donne tout de suite les réponses à toutes vos questions et fait tout le boulot pour vous, vous n’avez plus qu’à copier-coller. ChatGPT est un «agent conversationnel» qui utilise l’IA (intelligence artificielle) et qui compte déjà plus de 100 millions de comptes enregistrés. Ses promoteurs affirment que ChatGPT pourrait à terme disposer d’une intelligence artificielle proche des capacités offertes par le cerveau humain. Une bonne nouvelle ?

Un tas de questions se posent : risque de manipulations, de détournements, de suppressions d’emploi, de confidentialité, de plagiats... mais surtout le risque d’une intelligence servile et sans pensée. Le pire est sans doute l’irresponsabilité. Pour Martine Leibovici et Aurore Mréjen, qui ont dirigé le numéro spécial des Cahiers de l’Herne sur Hannah Arendt, «ne plus se sentir responsable de ce que l’on fait, voilà le ressort de la banalité du mal» pour Hannah Arendt. Pour Noam Chomsky et ses collègues, ChatGPT est «une fausse promesse».

"Là-bas" vous propose la traduction en français d’une récente tribune de Noam Chomsky avec Ian Roberts, professeur de linguistique, et Jeffrey Watumull, directeur du pôle Intelligence artificielle de la société Oceanit, publiée le 8 mars 2023 dans le New York Times.corps

Jorge Luis Borges a écrit un jour que vivre dans une période de grand danger et de grands espoirs, c’était faire à la fois l’expérience de la tragédie et de la comédie, avec «l’imminence d’une révélation» dans notre compréhension du monde et de nous-mêmes. Aujourd’hui, les avancées prétendument révolutionnaires de l’intelligence artificielle sont effectivement source à la fois d’inquiétude et d’optimisme. D’optimisme parce que l’intelligence est un outil qui nous permet de résoudre des problèmes. D’inquiétude parce que nous redoutons que le courant le plus répandu et le plus en vogue de l’intelligence artificielle – l’apprentissage automatique – discrédite notre science et dénature notre éthique en intégrant dans notre technologie une conception fondamentalement fausse du langage et du savoir.

* * * *

ChatGPT, Chomsky et la banalité du mal

Martin Legros publié le 13 mars 2023

Dans une tribune parue dans le New York Times, le philosophe et linguiste Noam Chomsky balance du lourd contre le robot de conversation ChatGPT, qu’il accuse de «disséminer dans l’espace public un usage dévoyé du langage et de la pensée susceptible de faire le lit de ce que Hannah Arendt appelait "la banalité du mal"». Voilà une charge qui mérite d’être examinée.

C’est une question essentielle que soulève Noam Chomsky dans la tribune qu’il a publiée avec Ian Roberts, linguiste à l’université de Cambridge, et Jeffrey Watumull, philosophe spécialiste d’intelligence artificielle. Une question qui touche à l’essence du langage, de la pensée et de l’éthique. Dans la confrontation avec l’intelligence artificielle, affirment-ils, c’est le propre de l’intelligence humaine qui apparaît et qui doit être préservé : si nous sommes capables, nous les hommes, de générer de la pensée et du langage, c’est que nous entretenons un rapport intime et fondamental, dans notre créativité même, avec la limite, avec le sens de l’impossible et de la loi. Or, la "fausse promesse" de l’intelligence artificielle, selon le titre de la tribune, est de nous faire miroiter qu’il serait possible d’obtenir les mêmes performances en se passant de cette confrontation à la limite et à la règle qui fait le ressort de l’expérience humaine. Tentons de suivre cette démonstration, hautement philosophique.

On comprend que Chomsky se soit senti mis en demeure de se pencher sur les nouveaux robots conversationnels tels que ChatGPT, Bard ou Sydney. Fondateur de l’idée de grammaire générative, le philosophe soutient en effet que les hommes disposent avec le langage d’une compétence à nulle autre pareille, une puissance intérieure de générer et de comprendre, grâce à un nombre fini de règles, un nombre infini de propositions qui expriment leur pensée. Or, quand ChatGPT parvient à générer des réponses sensées à nos questions sur la base des millions d’énoncés que le système a appris automatiquement, qui dit que le robot ne parle et ne pense pas à son tour ? Qu’il ne génère pas du langage et donc de la pensée ? La réponse de Chomsky est profonde et subtile. Elle part, comme souvent chez lui, d’un petit exemple grammatical : "John is too stubborn to talk to." Tout locuteur anglais lambda comprendra immédiatement le sens de cette phrase sur la base de sa connaissance de la langue et de la situation dans laquelle elle est proférée. Elle signifie : "John est trop têtu pour qu’on le raisonne." Où John, sujet initial, bascule implicitement en complément d’objet, et où le "talk" signifie "raisonner" et non pas "parler". L’IA, elle, sera induite à comprendre : "John est trop têtu pour parler à quelqu’un." Parce qu’elle n’a pas accès à la règle ni à la situation, elle cherche en effet à prédire la bonne signification d’un énoncé sur la base du plus grand nombre d’occurrences analogiques. Mais de même que "John a mangé une pomme" équivaut souvent à "John en a mangé", de même, "John est trop têtu pour parler" a des chances de vouloir dire "John est trop têtu pour parler à quelqu’un" davantage que "pour qu’on le raisonne".

Au vu des performances des nouveaux logiciels de traduction, tels que DeepL – dont j’ai d’ailleurs dû m’aider pour être sûr de bien comprendre l’exemple de Chomsky – on pourrait être tenté de relativiser cette confiance que fait ici le philosophe dans l’intelligence humaine du langage. Mais le raisonnement monte en puissance quand il touche à la loi, scientifique ou éthique. Soit l’énoncé "la pomme tombe" ou "la pomme tombera", formulé après que vous avez ouvert la main ou que vous envisagiez de le faire. Une IA est à même de formuler chacune de ces deux propositions. En revanche, elle sera incapable de générer l’énoncé : "La pomme ne serait pas tombée sans la force de la gravité." Car cet énoncé est une explication, c’est-à-dire une règle qui délimite le possible de l’impossible. On tient là pour Chomsky la ligne de partage entre les deux intelligences. En dépit de la puissance d’apprentissage et de calcul phénoménal qui est la sienne, l’intelligence artificielle se contente de décrire et/ou de prédire à partir d’un nombre potentiellement infini de données, là où l’intelligence humaine est capable, avec un nombre fini de données, d’expliquer et de réguler, c’est-à-dire de délimiter le possible et l’impossible. Notre intelligence ne se contente pas définir ce qui est ou ce qui pourrait être ; elle cherche à établir ce qui doit être.

Cette approche a une portée éthique évidente. Car la morale consiste à "limiter la créativité autrement illimitée de nos esprits par un ensemble de principes éthiques qui déterminent ce qui doit être et ce qui ne doit pas être (et bien sûr soumettre ces principes eux-mêmes à une critique créative)". À l’inverse, comme en attestent les réponses produites par ChatGPT aux questions éthiques qu’on lui pose, et qui se réduisent à une recension des différentes positions humaines, l’IA trahit une "indifférence morale". Et Chomsky de conclure : «ChatGPT fait preuve de quelque chose comme la banalité du mal : plagiat, apathie, évitement. Ce système offre une défense du type "je ne fais que suivre les ordres" en rejetant la responsabilité sur ses créateurs.» Pour en avoir le cœur net, je suis allé demander à ChatGPT s’il connaissait l’idée de banalité du mal et s’il se sentait concerné. Voilà ce qu’il m’a répondu : «Il est vrai que je suis un outil créé par des humains, et par conséquent, je peux refléter les limites et les biais de mes créateurs et des données sur lesquelles je suis entraîné.» Une intelligence servile et sans pensée, c’est en effet une bonne définition de la banalité du mal. Et de l’intelligence artificielle !

* * * *

Une "intelligence servile et sans pensée" va-t-elle contrôler l’humanité dans les années qui viennent ?

Voici quelques exemples de ce qui se passe depuis le lancement de la nouvelle version du robot d’intelligence artificielle ChatGPT-4 il y a un peu plus de deux semaines seulement : tandis qu’Internet est inondé d’images générées par IA montrant le pape aux platines ou Donald Trump arrêté par la police, en Belgique, une IA conversationnelle est soupçonnée d’avoir poussé un homme souffrant d’écoanxiété au suicide. Une étude de Goldman Sachs a annoncé que près de 300 millions d’emplois seraient impactés par la montée en puissance des IA, et une seconde publiée voici 3 jours seulement indiquent que 49% des entreprises sondées utilisent déjà ChatGPT, disent avoir déjà remplacé des salariés et s’apprêtent à en remplacer d’autres.

Tandis que l’on annonce que certaines AI pourraient prevent the next pandemic ou aider à prévenir le cancer, le linguiste Noam Chomsky, a publié dans le New York Times une tribune alarmante sur les conséquences morales de l’utilisation massive des IA, Yuval Noah Harari l’auteur de Sapiens, a écrit qu’en s’emparant du langage, l’intelligence artificielle s’offrait le sésame de la civilisation, 1300 chercheurs, scientifiques, et grandes figures de la tech dont Elon Musk et le co-créateur d’Apple, Steve Wozniak, ont signé un appel demandant une pause sur les expériences géantes d’intelligence artificielle, certains ont comparé ChatGPT à l’invention de la bombe atomique, et le chercheur et théoricien en Intelligence artificielle Eliezer Yudkowsky, est allé jusqu’à prédire la fin de l’humanité à court terme dans le cas contraire. Enfin, on apprend ce week-end que ChatGPT a été temporairement interdit en Italie.

* * * *

Intelligence artificielle : cauchemar ou révolution ?

OpenAI vient de lancer une nouvelle IA, ChatGPT. Alors que l’IA prend de plus en plus de place dans nos vies, certains s’inquiètent de dérives. Les journalistes d’investigation des Forbidden Stories relatent dans leur enquête “Story Killers” l’ampleur de l’industrie de la désinformation.

Avec :

Pierre Cassou-Noguès Philosophe et mathématicien. Auteur d’un essai sur la philosophie de Jean Cavaillès (Vrin, 2002)

Martin Legros Rédacteur en chef de Philosophie magazine

Marine Protais Journaliste

Intelligence artificielle La guerre de la désinformation

24heures du samedi-dimanche 06 janvier 2024

Nouvelle technologie

Pour l’alma mater genevoise, les outils comme ChatGPT offrent une plus-value. À condition d’en faire un usage éclairé.

Aurélie Toninato

Il y a un an, l’arrivée de ChatGPT a ouvert une nouvelle ère dans l’utilisation des outils d’intelligence artificielle (IA). Ce logiciel conversationnel gratuit, créé par la société OpenAI, est capable de répondre en direct aux questions d’un utilisateur et de rédiger des textes en se basant sur des algorithmes et des milliards de données sur internet.

L’outil a suscité de l’engouement mais aussi de l’inquiétude, notamment dans le milieu de l’enseignement. Allait-il concurrencer la production humaine de contenu? Devenir un moyen perfectionné de triche ?

Dans une prise de position publiée cet été, l’Université de Genève (UNIGE) déclare que «l’objectif n’est pas de contrer l’IA, mais d’en tirer le meilleur parti et d’en contenir les aspects problématiques». Elle mise sur la formation pour «cerner ses caractéristiques, bénéfices et limites» (sic).

Ateliers de sensibilisation

Trois ateliers à l’attention des étudiants ont ainsi eu lieu en décembre, animés par Jehan Laliberté, entrepreneur indépendant vaudois de 25 ans et expert en intelligence artificielle qui aide les entreprises à adopter l’IA de manière concrète. «Le but de l’Université de Genève n’est pas de pousser à l’utilisation de ces outils mais de sensibiliser les étudiants aux dangers et aux bonnes pratiques, pour un usage éthique et responsable», précise-t-il.

Durant ses interventions devant les élèves, le spécialiste a décortiqué les rouages du fonctionnement de plusieurs de ces outils, en particulier ChatGPT. «Cette compréhension est essentielle pour déceler les limites du système et développer un esprit critique.»

Parmi ces faiblesses, il cite les «hallucinations». «L’outil peut générer des réponses fausses qui paraissent crédibles. Il ment de manière très convaincante! Il est programmé pour fournir la réponse qui correspond le mieux au contexte donné par la question.» Autre biais: la version gratuite de l’outil ne cite pas les sources de ses assertions. «Impossible, donc, de vérifier les informations transmises.»

Des techniques existent toutefois pour optimiser les réponses. «Il faut formuler ses questions avec de nombreux éléments de contexte. Certains prompts (ndlr: instructions) augmentent la qualité de la réponse, comme demander au logiciel de se mettre dans le rôle d’un expert - «Réponds comme un spécialiste en stratégie marketing» par exemple. On peut aussi spécifier à l’outil d’indiquer s’il ne connaît pas la réponse.»

Une fois cet art de la conversation maîtrisé, quelles applications utiles pour les étudiants? Une aide à l’apprentissage personnalisée et à la révision notamment, répond Jehan Laliberté. «L’IA devient une sorte de partenaire d’entraînement. On peut demander au logiciel de nous questionner sur un sujet de manière écrite ou orale.» Lui fournir, également, des PDF et des notes de cours dont il va tirer des questions-réponses ou des résumés, lui demander de vulgariser un concept comme s’il devait l’expliquer à un enfant, de livrer un retour sur nos réponses, de remettre au propre des notes dactylographiées, d’organiser les révisions selon des objectifs, entre autres...

Évaluation en question

L’IA peut aussi produire des textes à la syntaxe, sémantique et orthographe assez bluffantes, et devenir un moyen de triche.

«Ces outils peuvent stimuler la réflexion et la formation d’un esprit critique, à condition de les utiliser correctement. On conseille évidemment aux étudiants d’utiliser les textes générés comme source d’inspiration, comme base, mais il est inévitable que certains s’en serviront autrement. La démocratisation de l’IA va remettre en question le modèle d’évaluation des étudiants.»

Prise de position de l’UNIGE

En juillet, l’Université de Genève a émis une série de recommandations sur l’utilisation de l’IA générative. Reconnaissant que ces outils présentent «un intérêt certain et peuvent apporter une plus-value importante aux enseignants, aux chercheurs et aux étudiants», elle souligne que leurs limites sont réelles. Il est de la responsabilité de la communauté universitaire d’en faire un usage éclairé, et l’institution se doit de proposer des mesures d’accompagnement.

En plus des ateliers destinés aux étudiants, des formations sont offertes aux enseignants pour présenter le fonctionnement de ces outils, les moyens de détecter l’utilisation de l’IA dans les productions étudiantes, les apports dans l’enseignement (plan de cours, critères d’évaluation, activités), etc.

Des consignes claires quant à l’utilisation de ces outils ont été édictées par les facultés. L’institution précise aussi que l’évaluation des apprentissages doit désormais être conçue en tenant compte de ’existence de l’IA. «Cela peut se traduire, par exemple, par des travaux de groupes, des évaluations centrées sur les connaissances individuelles (examens avec une partie orale) ou pour lesquelles l’usage de l’IA perd de sa pertinence (examens avec de la pratique)». ATO

«L’IA devient une sorte de partenaire d’entraînement.»

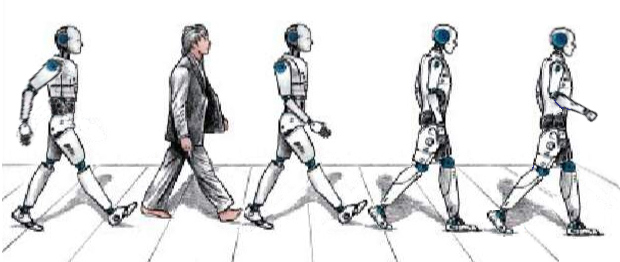

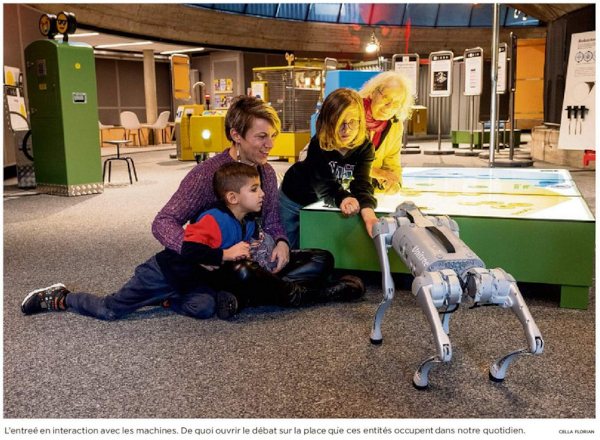

Nous devons questionner les liens entre les hommes et les machines avant que ces machines nous dominent complètement.

Les machines, les automates et androïdes ont occupé une place démesurée dans notre histoire, dans notre société et notre imaginaire collectif et, face à eux, nos sentiments oscillent entre malaise, goguenardise et fascination. Il n’est pas facile, au fur et à mesure des interactions, de mieux comprendre notre goût pour la technologie

Qu’elle est la place que devraient occuper les machines dans notre quotidien? Le robot nous stimule au sens propre d’une façon interactive et au figuré mais il nous pose et soulève de nombreuses questions. Comment aborder du point de vue éthique le robot, surtout un robot émotionnel d’assistance thérapeutique? Une machine mignonne comme un bébé phoque qui est utilisée auprès de personnes atteintes de la maladie d’Alzheimer ou de troubles apparentés. Douce comme un chat, la machine est posée sur les genoux des patients et patientes, interagit avec eux en douceur, en réagissant par exemple à leurs caresses. Un peu comme un animal de compagnie, mais sans les risques de morsures, griffures ou allergies.

Le dispositif sert à apaiser les patients et les soignants peuvent réduire les doses de médicaments de type calmants administrés. Mais, ce faisant, ne manipule-t-on pas les malades à qui on dissimule la véritable nature du robot ?

Retour à ma page - l’analyse de l’IA - compilation d’articles de divers journaux

Le vrai piège de l’IA - la disparition du corps - Echosciences Grenoble

Les pièges invisibles - de l’intelligence artificielle - Linkedin publié le 28 janvier 2022

Le piège de l’IA ... est-ce vraiment aussi révolutionnaire ? - You Tube

L’IA a-t-elle une conscience ? - Même les spécialistes tombent dans le piège - Sciences et Avenir

Contagion, désinformation, court-termisme - 14 pièges évolutifs dans lesquels s’engouffre l’humanité - L’Humanité du 24.11.23

page compilée par G.P.T. - janvier 2024

* NDComp = notes du compilateur G.P.T.

page checked by...