Grandes Menaces programmées

P32 - Sommaire :

PME Magazine le 10.10.2024

Intelligence artificielle

Les attaques de cybercriminels à l’aide de technologie deepfake sont en augmentation, y compris en Suisse. Comment les entreprises peuvent-elles limiter les risques en la matière? Conseils pratiques.

Par Erik Freudenreich

Il y a quelques mois, le responsable financier d’une entreprise suisse recevait un coup de fil pour l’inviter à une visioconférence avec son chef. En se connectant, le CFO voit et échange avec son supérieur.

Mais durant la conversation, ce dernier tente d’obtenir des informations sensibles et de convaincre le responsable financier de réaliser une transaction financière. Heureusement, plusieurs détails ont mis la puce à l’oreille de la personne ciblée: la tenue vestimentaire de son chef sortait de l’ordinaire et sa voix ne lui était pas complètement familière.

L’essor des escroqueries utilisant la technologie deepfake

Voilà un cas signalé à l’Office fédéral de la cybersécurité (OFCS) ce printemps recourant à la technologie deepfake. Pour rappel, cette dernière consiste à générer des contenus audio ou vidéo en utilisant des échantillons de la voix et de l’apparence de la personne ciblée. L’OFCS enregistre un nombre croissant de plaintes en lien avec des tentatives de fraude qui emploient des technologies liées à l’intelligence artificielle: «Les cybercriminels utilisent des images générées par l’IA pour des tentatives de sextorsion, se font passer pour des personnalités connues au téléphone ou réalisent des escroqueries à l’investissement.» Bien que le nombre de signalements dans ce domaine soit encore relativement faible, il s’agit, selon les estimations de l’OFCS, de premières tentatives d’explorer les possibilités d’utilisation criminelle de l’IA pour mener de futures cyber-attaques.

Dans certains cas, ces tentatives peuvent coûter très cher. Ainsi, l’entreprise britannique Arup, un bureau d’ingénieurs notamment à l’origine de l’Opéra de Sydney, a récemment confirmé avoir été la cible d’une escroquerie recourant au deepfake qui a amené un de ses collaborateurs à verser 25 millions de dollars à des cybercriminels.

«Il faut se rendre compte que les organisations criminelles préparent ces attaques de la même manière qu’un braquage de banque, raconte Paul Such, CEO de la société vaudoise Hacknowledge, spécialisée dans la cybersécurité. Elles intègrent ainsi une longue phase de reconnaissance, qui permet de se renseigner sur le style de la personne ciblée, ses absences, etc. On m’a rapporté récemment le cas d’une société suisse qui a perdu 8 millions de francs à cause d’une arnaque au deepfake. Heureusement, ces transferts sont souvent bloqués au dernier moment par l’établissement bancaire de l’entreprise ciblée.»corps

L’expert remarque lui aussi une augmentation des tentatives criminelles qui intègrent ces nouvelles technologies. «Aujourd’hui, en Suisse, les fraudeurs ont principalement recours à des enregistrements audio. Cela s’explique sans doute par le fait que les outils sont pour l’instant surtout entraînés en langue anglaise, mais il n’y a aucun doute que l’on va voir arriver davantage de vidéos réalistes en français dans un futur proche.»

Sensibilisation et formation: des outils essentiels pour contrer les attaques

Le problème principal posé par ces approches ne concerne pas la technique, mais le fait qu’elles reposent sur la crédulité des utilisateurs. «Tous les artifices sécuritaires possibles ne servent à rien si les employés ne sont pas régulièrement sensibilisés à ces questions. Aussi, notre industrie a essayé ces dernières années de faire progresser les utilisateurs en envoyant de fausses tentatives de phishing et en notant qui se faisait avoir. Mais ce n’est qu’une partie de l’équation: il est aussi intéressant de pouvoir identifier le nombre de collaborateurs qui se rendent compte d’une attaque et qui appliquent les bons réflexes, notamment en prévenant leur service informatique.»

La formation des employés est cruciale pour la cybersécurité d’une organisation, souligne également Christian Da Silva, président de CyberHelvet, une entreprise genevoise spécialisée dans la cybersécurité et membre de l’Observatoire des risques opérationnels (Oprisko), une association à but non lucratif qui traite de la maîtrise des risques d’entreprise. «Comme les employés sont souvent les premières cibles des attaques, une formation régulière aide à réduire les erreurs qui pourraient compromettre la sécurité. Il s’agit par ailleurs de promouvoir une véritable culture de la cybersécurité pour contribuer à renforcer les défenses globales de l’entreprise.»

Un avis partagé par Paul Such, de la société Hacknowledge. «Cet état d’esprit doit être instillé par la direction pour que les employés prennent pleinement conscience des risques encourus. Aussi, cette évangélisation auprès des utilisateurs finaux doit s’accompagner d’explications concrètes de l’utilité des mesures mises en place.»

Certify, pour distinguer le vrai du faux

La start-up genevoise Certify développe une application qui aide les internautes à mieux identifier les informations douteuses.

Les graines de chia sont-elles vraiment un aliment miracle, comme le professe cet influenceur sur TikTok? «Non, il manque des études à ce sujet, et la personne qui en parle à l’écran est coach sportif et non pas nutritionniste.» Voilà un exemple de contextualisation que l’on peut découvrir en utilisant l’application genevoise "Certify". Concrètement, celle-ci permet aux utilisateurs d’envoyer le contenu d’un réseau social ou d’un site web sur la plateforme Certify pour faire appel à l’avis d’un expert. Celui-ci rédige ensuite une fiche qui résume les principaux points d’attention concernant le contenu soumis et intègre des liens vers les sources utilisées.

«Nous voulons aider le public à développer son aptitude à comprendre et à utiliser les informations, explique Fayez Alrafeea, cofondateur et responsable du développement technique de Certify. Il existe aujourd’hui un vrai problème de ’littératie médiatique’ – soit la capacité à analyser les contenus médiatiques – chez les jeunes générations. D’autant plus que si les gens pensent souvent en premier lieu aux fake news en lien avec la politique ou la santé, cela concerne de nombreux autres domaines comme le sport ou les divertissements.»

L’application est actuellement en phase de test dans différentes écoles de la région genevoise. «Les principaux défis techniques ont été résolus, et nous sommes désormais à la recherche de nouveaux investisseurs pour une mise à l’échelle du projet, précise Basile Zimmermann, cofondateur. Nous allons par ailleurs prochainement déployer la plateforme en Suisse alémanique et développons aussi des partenariats à l’étranger.»

Cibler efficacement les investissements en cybersécurité

les critiques ne se sont pas fait attendre :

«l’AI ne donne aucune réponse ou des réponses erronées, ses réactions sont beaucoup trop lentes et son utilisation est compliquée, la batterie s’épuise au bout de deux heures, le pire produit jamais testé, défectueux dans tout ce qu’il fait, presque toujours et tout simplement «inutilisable». On parle d’une idée stupide plutôt que d’intelligence artificielle.»

a déclaré un utilisateur

Certify Système online de demande de légalisations

Exemple de Vœux pieux

Guide ultime de l’IA pour le travail

Qu’apporte réellement l’IA depuis un an et demi ?

Les créations générées ne sont pas protégées !

Aucune intelligence artificielle n’est neutre. Toutes ont été créées selon un modèle, un but, un intérêt

Le Courrier du mercredi 09 octobre 2024

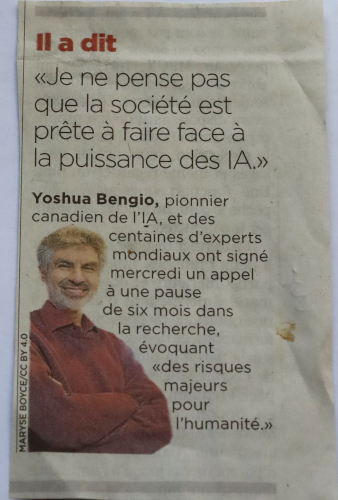

Un pionnier de l’IA nous avertit

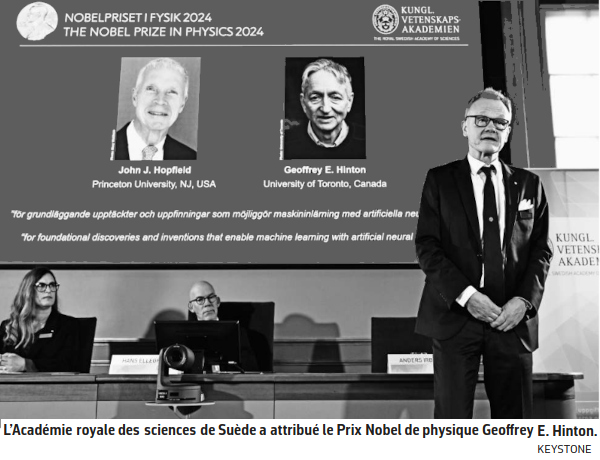

John Hopfield et Geoffrey Hinton ont travaillé sur l’IA. On risque de la voir rivaliser un jour avec des lauréats !

Prix Nobel de physique

Le Prix Nobel de physique a été attribué mardi à l’Américain John Hopfield et au Canadien d’origine britannique Geoffrey Hinton. Ils sont récompensés pour leurs découvertes fondamentales sur l’apprentissage automatique et les réseaux neuronaux artificiels. Ils travaillent sur le sujet depuis les années 1980. John Hopfield, 91 ans et professeur à l’Université de Princeton, aux Etats-Unis, et Geoffrey Hinton, 76 ans et professeur à l’Université de Toronto, au Canada, «ont utilisé des concepts fondamentaux de la physique statistique pour concevoir des réseaux de neurones artificiels qui fonctionnent comme des mémoires associatives et trouvent des modèles dans de grands ensembles de données» a précisé Ellen Moons, présidente du comité Nobel de physique, devant la presse.

Inquiétudes pour l’avenir

Ces modèles «ont été utilisés pour faire avancer la recherche dans des domaines aussi divers que la physique des particules, la science des matériaux et l’astrophysique, et ils font désormais partie de notre vie quotidienne» comme la reconnaissance faciale et la traduction automatique, a-t-elle poursuivi. L’Américain John Hopfield a en particulier donné son nom au «réseau Hopfield», c’est-à-dire «une mémoire associative qui peut stocker et reconstruire des images et d’autres types de modèles», selon le jury. Geoffrey Hinton, lui, est parti du réseau Hopfield pour créer un nouveau réseau utilisant une méthode différente, «la machine Boltzmann». Il a ainsi «inventé une méthode capable de trouver de manière autonome des propriétés dans les données, et donc d’effectuer des tâches telles que l’identification d’éléments spécifiques dans des images».

«Je crains que la conséquence globale de tout cela ne soit des systèmes plus intelligents que nous qui finissent par prendre le contrôle», a ajouté le chercheur. Lauréat du Prix Turing 2018, il avait annoncé son départ de Google en mai 2023 pour pouvoir alerter des dangers de l’IA.

Un robot à découvertes

Cette technologie pourrait même être la prochaine rivale des lauréats du Nobel. Les scientifiques jugent qu’elle pourrait révolutionner la recherche. En 2021, le Japonais Hiroaki Kitano lance ce qu’il baptise le Nobel Turing Challenge. Il met les chercheurs au défi de créer un «scientifique de l’IA» capable de mener de manière autonome des recherches dignes d’un Prix Nobel d’ici à 2050.

Certains chercheurs travaillent d’arrache-pied à créer un tel collègue artificiel et une centaine de «robots scientifiques» sont déjà à l’œuvre dans la science, explique Ross D. King, professeur d’intelligence artificielle à l’Université de Chalmers, en Suède. Le spécialiste a publié dès 2009 un article dans lequel il présentait, avec d’autres chercheurs, un robot scientifique baptisé Adam, la première machine à produire des découvertes scientifiques de manière autonome.

Le robot a été programmé pour formuler des hypothèses de façon autonome, concevoir des expériences pour les tester et même programmer d’autres robots de laboratoire pour réaliser ces expériences et enfin apprendre à partir de ces résultats. Un deuxième robot scientifique appelé Eve a été ensuite créé pour étudier les médicaments candidats contre le paludisme et d’autres maladies tropicales.

Impact sur la science

Avec de tels robots, «cela coûte moins d’argent de mener des recherches et ils travaillent 24h sur 24», explique Ross D. King, ajoutant qu’ils sont en outre plus rigoureux dans le suivi des processus. Le chercheur concède cependant que l’IA est loin d’être à la hauteur d’un scientifique méritant le Nobel. Il faudrait pour cela des robots «beaucoup plus intelligents» capables de «comprendre la situation dans son ensemble» pour rivaliser avec les Nobel.

«La tradition scientifique n’est pas près d’être remplacée par des machines», abonde Inga Strümke, professeur associée à l’Université norvégienne des sciences et technologies. «Cela ne signifie pas que c’est impossible», ajoute-t-elle, estimant qu’il est «certainement clair que l’IA a et aura un impact sur la manière dont la science est menée.»

Le modèle d’IA Alphafold, développé par Google Deepmind, qui permet de prédire la structure tridimensionnelle des protéines en fonction de leur acide aminé, en est un bon exemple.

«Je suis inquiet que l’IA puisse devenir plus intelligent que nous et que la conséquence globale de tout cela ne soit des systèmes plus intelligents que nous qui finissent par prendre le contrôle.»

Geoffrey Hilton - pionnier de l’IA et prix Nobel de physique lors de son attribution |

(NDC - commentaire...

Encore une fois on peut remarquer que derrière les paroles dithyrambiques des chercheurs et autres experts de l’IA, on peut constater une inquiétude cachée qui transparaît sans que, semble-t-il, cela amène à des mises en question ni même à des avertissements quant-aux problèmes que tout cela pose. Certes ces scientifiques articulent quelques craintes mais elles sont cependant vite noyées dans leurs défenses de l’IA qui, pour eux, semble être le pinacle d’un progrès inouï. Tout le problème est là, entre les supposés "bienfaits" de l’IA et ses dangers, le choix est vite fait, on privilège d’abord la gloire obtenue par cette IA invincible et dominante, porteuse d’espoirs hypothétiques...)

Liens

Geoffrey Hinton - warns about the growing dangers of AI

Geoffrey Hinton - now scared of the tech he helped build

* * * *

Commentaires

IA et ses conséquences

Il y a une fatigue vis-à-vis de la multiplication des supports numériques, des stimulii technologiques et des progrès fulgurants que permet l’IA.

Les gens sont déstabilisés, leur position dans la société fragilisée et ils cherchent désespérément des soutiens qui peuvent les réconforter et même les éclairer. Le progrès technologique fait de nous des pantins influençables, robotisés par une IA et ses succédanées. D’où l’essor des «influenceurs-influenceuse», des figures notables charismatiques, des personnalités qui peuvent les guider.

Déconcertés par l’omniprésence informatique et du virtuel envahissant, les gens détachés de la réalité, sont à la recherche de mentors, de modèles et d’expériences réelles d’où le succès des conférences et des rencontres avec des personnalités.

(d’après un article sur «Les rencontres avec des personnalités» du 14 octobre 2024)

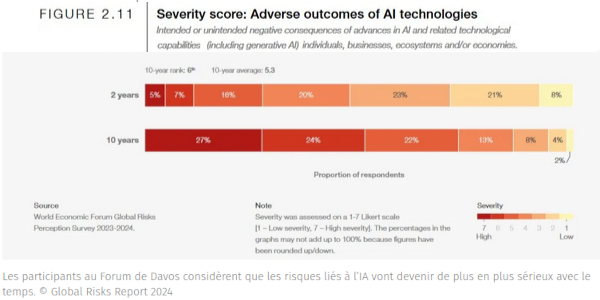

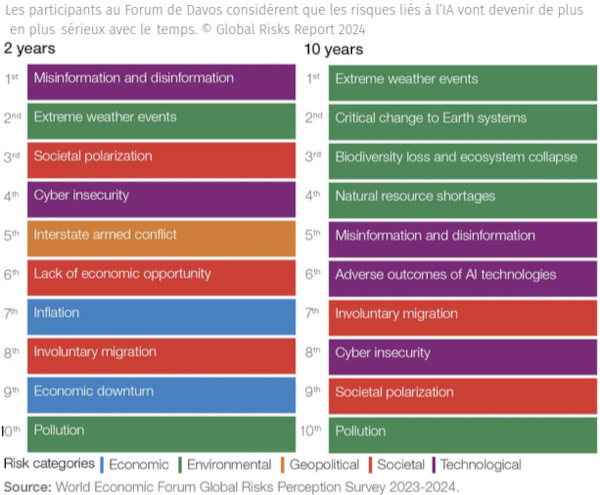

Journal du Geek - Antoine Gautherie - 15 janvier 2024

Ce 15 janvier marque l’ouverture du Forum économique mondial, plus connu sous le nom de Forum de Davos. Les participants de cette grand-messe des affaires et du lobbying ont dévoilé leur liste des 10 menaces les plus importantes pour l’humanité, à court et à moyen terme : ci-dessous ce que le gratin de l’économie mondiale pense de notre futur commun. Avec la crise climatique, l’intelligence artificielle se place parmi les thématiques qui inquiètent le plus les participants du Forum économique mondial.

Ce sondage annuel appelé Global Risk Report propose à cette cohorte de grands patrons, de milliardaires, de banquiers et de responsables politiques de classer les différents risques encourus par l’humanité en fonction de leur sévérité. Ces pronostics sont séparés en plusieurs catégories distinctes. La première d’entre elles porte sur le court terme, et plus spécifiquement sur l’année à venir.

Du climat et de l’IA

Sans surprise, la grande majorité des sondés (66%) estime que ce sont les phénomènes climatiques extrêmes qui seront le plus à même de provoquer une crise globale en 2024. Les votants ont insisté sur le fait qu’en dépit d’une certaine prise de conscience collective, les décideurs politiques traînent encore à joindre la parole aux actes. Selon eux, les nations restent très mal préparées au «déclenchement d’effets sur le long terme potentiellement irréversibles et autoentretenus» qui menacent de défigurer notre planète.

En deuxième position, on retrouve une thématique qui ne cesse de faire les gros titres depuis quelques mois : l’intelligence artificielle. 53% des sondés considèrent que les risques posés par cette technologie constituent une menace majeure à court terme – plus que la polarisation sociale et politique (46%) et la crise du coût de la vie (42%).

Une technologie qui inquiète

Pour expliquer cette méfiance vis-à-vis de cette technologie, les participants du Forum citent surtout les risques de désinformation. «Dans les mains des mauvais acteurs, l’IA a le potentiel d’inonder les systèmes d’information globaux de fausses informations», explique le rapport. Et apparemment, ils considèrent que ce risque va s’accentuer. Sur les deux prochaines années, la désinformation passe même en première position des risques globaux, devant les événements climatiques extrêmes et la polarisation sociétale. Ce dépassement est lié aux grandes échéances qui attendent l’humanité dans cet intervalle de temps.

Les votants estiment que ces risques sont d’autant plus importants en cette période d’élections. En effet, plus de trois milliards de personnes qui vont prendre le chemin des urnes d’ici 2026. Cela concerne notamment l’ Inde, les États-Unis et le Royaume-Uni. Dans ce contexte, la désinformation alimentée par des outils basés sur l’IA «pourrait déboucher des troubles civils, alimenter une censure gouvernementale, une propagande domestique et un contrôle sur la libre circulation de l’information».

Les votants estiment toutefois que ce risque finira par s’amenuiser. Dans le classement des risques sur les 10 prochaines années, la désinformation tombe en 5e position. Elle se place derrière quatre risques de nature écologique : les événements climatiques extrêmes, les changements critiques aux systèmes de la Terre, l’effondrement des écosystèmes et de la biodiversité, et les pénuries de ressources naturelles. Un constat pas dénué d’ironie, sachant que chaque année, près de la moitié des participants arrivent à Davos… en jet privé.

Mais dans ce classement sur le long terme, on constate aussi l’apparition d’une autre thématique en 6e position : les «conséquences néfastes des technologies d’IA». Par exemple, les participants semblent inquiets à l’idée de voir émerger une intelligence artificielle générale (AGI) en tout point supérieure à celle des humains. Ils citent également le remplacement de certaines branches professionnelles, l’usage de cette technologie à des fins militaires ou de cybercriminalité, ou le rôle qu’elle pourrait jouer dans la prise de décision par les gouvernements et les institutions.

Innovation contre principe de précaution

«À ce jour, le principe de précaution n’a globalement pas été appliqué dans le développement de l’intelligence artificielle, et les régulateurs se sont rangés du côté de l’innovation», peut-on lire dans le rapport. «L’évolution rapide et la dépendance aux IA avancées commencent à surpasser notre capacité à nous y adapter, que ce soit lorsqu’il s’agit de comprendre la technologie en elle-même (problème de la boîte noire) ou de créer des garde-fous réglementaires.» Ce discours fait écho aux appels de nombreux spécialistes qui ne cessent de réclamer une régulation plus stricte du machine learning. On se souvient notamment de la fameuse tribune signée par 1300 personnalités influentes, dont Elon Musk, qui réclamaient une approche plus précautionneuse. La bonne nouvelle, c’est que même si sa pertinence est souvent remise en question, le forum de Davos reste un événement auquel la sphère politique et les grandes entreprises continuent de prêter une attention toute particulière.

Il sera donc intéressant de voir ce que les décideurs politiques et les chefs de file de cette niche technologique vont retenir de ce rapport. On pense notamment à Emmanuel Macron, partisan revendiqué d’une approche très libérale sur la régulation de l’IA, et aux cadors de l’industrie comme OpenAI qui ont un intérêt financier à s’affranchir du principe de précaution.

Questions pertinantes

WEF - Global Risks Report 2024

Quels sont les réels dangers - de l’intelligence artificielle ?

Dangers de l’IA : le chef de l’ONU appelle à une réponse "unie" et "globale"

* * * *

Les familles d’attaque :

Lire plus :

Cybersécurité en 2024 : l’année IA de tous les dangers !

24heures du samedi 19 octobre 2024

Selon les constats de plusieurs scientifiques, certaines avancées technologiques liées à l’IA pourraient menacer l’humanité.

Pascal Gavillet

Il y a un peu plus d’une semaine, le Nobel de physique était attribué conjointement à John Hopfield et Geoffrey Hinton pour leurs découvertes fondamentales sur l’apprentissage automatique et les réseaux neuronaux artificiels. Ces deux pionniers de l’intelligence artificielle (IA) avaient utilisé des outils de la physique pour développer des méthodes qui sont à la base des puissants systèmes d’apprentissage automatique d’aujourd’hui. Quant aux réseaux neuronaux artificiels, ils ont leur rôle à jouer dans la physique des particules, la science des matériaux et l’astrophysique. Rien que ça !

Dans ce cas-là, l’apport de l’IA est globalement positif. Mais ce n’est pas toujours le cas. Au point qu’on est en droit de se demander si l’homme ne serait pas par nature rétif aux avancées technologiques. Dans certains cas, il faut même répondre à cette question de manière positive. Surtout en ce qui concerne l’IA, responsable de bien des problèmes, à en croire certains. Augmentation du chômage, mais aussi de la cybercriminalité, du terrorisme de masse et même de l’épuisement des ressources planétaires.

Menace pour l’humanité

L’IA porte souvent le chapeau, et les gens ont globalement tendance à s’en méfier, comme on peut se méfier de tout ce qu’on ne comprend pas ou mal. Ce qui suit va à son tour peser lourd dans le dossier. Car selon une étude menée conjointement par des chercheurs de Google et des scientifiques de l’Université d’Oxford, étude parue dans «IA Magazine» et régulièrement remise à jour, l’IA représenterait tout bonnement une menace sérieuse pour l’avenir de l’humanité.

Cette étude s’appuie sur un point important du développement et du fonctionnement des IA. À savoir ce qu’on nomme l’apprentissage par renforcement. Il s’agit d’une technique liée au développement d’algorithmes et aux modèles statistiques qui entraînent les logiciels à prendre des décisions en vue d’obtenir les meilleurs résultats possible. Elle reproduit un processus d’apprentissage par tâtonnements employé par les êtres humains pour atteindre leurs objectifs. Pour faire simple, les actions logicielles qui contribuent à la réalisation d’un objectif sont renforcées, tandis que les actions qui nuisent à celle-ci sont ignorées. Ce paradigme de récompense et de punition se voit ainsi activé pour tous les traitements de données.

Conséquences inattendues

Avec les IA, cette méthode permet ainsi d’obtenir des résultats optimaux. Au point qu’on se demande si une IA pourrait court-circuiter ce système de récompense mis en place par ceux qui l’ont créé. Et si c’était le cas, cette intervention pourrait avoir des conséquences inattendues et possiblement désastreuses.

En poussant plus loin le raisonnement et sa modélisation, des chercheurs ont imaginé une IA qui voudrait à tout prix maximiser sa récompense. Dans cette occurrence, l’humanité pourrait s’apparenter à une menace globale ou au mieux un obstacle qui se dresse sur le chemin de l’objectif à atteindre. Mais quels en seraient concrètement les effets? Les scientifiques en ont dégagé trois. L’élimination de n’importe quelle forme de menace, petite ou grande, qui se déclare comme telle. L’utilisation de toutes les énergies disponibles nécessaires pour sécuriser son système. Et enfin, conséquemment, le risque d’entrer en conflit direct avec les besoins des humains. C’est un peu, in fine, le mythe du créateur dominé puis dépassé par sa créature. La littérature scientifique en fournit d’innombrables exemples.

La solution des garde-fous

Afin que cela n’arrive pas, les chercheurs tirent la sonnette d’alarme et préconisent la mise en place de garde-fous qui agiraient sur le plan technique mais aussi sur celui de l’éthique. Les mécanismes d’apprentissage des IA, qui accumulent du savoir plus qu’elles ne raisonnent, doivent être repensés et mieux cadrés. Une vigilance qui est le prix pour maîtriser leur évolution et éloigner un danger potentiel mais réel.

Donc l’IA, c’est bien, du moins pour certaines choses, bien que l’impression d’un gadget inutile prédomine le plus souvent, mais c’est comme l’alcool, il ne faut pas en abuser et l’utiliser avec prudence.

En paraphrasant, on peut dire :

Dans l’espoir que cela n’arrivera pas, les chercheurs pensent tirer la sonnette d’alarme et préconiser la mise en place de garde-fous qui agiraient sur le plan technique mais aussi sur celui de l’éthique. Même si les mécanismes d’apprentissage des IA, qui accumulent du savoir plus qu’elles ne raisonnent, seraient repensés et mieux cadrés, même si une vigilance dans l’idée de maîtriser son évolution et éloigner un danger potentiel mais réel, la puissance de celle-ci est telle que tout cela ne sont que des vœux pieux irréalisables car il y a trop d’intérêts en jeu.

Donc on pourrait dire que l’IA est belle et bien un gadget inutile qui prédomine trop souvent, qu’elle est comme l’alcool, elle soûle lorsqu’on en abuse et c’est impossible de l’utiliser avec prudence.

«Aucune intelligence artificielle n’est neutre. Toutes ont été créées selon un modèle, un but, un intérêt.»

Une citation d’Anna Jobin, sociologue et spécialiste en éthique de l’IA |

«Avec l’IA générative, on trouve de nombreuses applications qui pourraient conduire à de fortes hausses de productivité.»

Une citation de Hendrik Remigerau, directeur du Merantix AI Campus |

«D’ici 2030, jusqu’à 30% des heures actuellement travaillées dans l’économie américaine pourraient être automatisées, une tendance accélérée par l’IA générative.»

Une citation du cabinet de conseil McKinsey |

«Vers 2029, l’IA atteindra le niveau de l’intelligence humaine. Continuez jusqu’à 2045, et nous aurons amplifié l’intelligence – celle de notre civilisation humaine et machine – par un milliard de fois.»

Une citation de Ray Kurzweil, inventeur et futurologue |

«Le développement d’une IA complète pourrait signifier la fin de la race humaine (...) Elle s’améliorera de manière autonome à un rythme croissant. Les humains, limités par l’évolution biologique lente, ne pourraient pas concurrencer et seraient dépassés.»

Une citation de Stephen Hawking à la BBC |

«Il est probable qu’une fois les machines seront capables de penser, elles surpasseront rapidement nos capacités (...) Capables de communiquer entre elles, elles pourraient prendre le contrôle à un moment donné.»

Une citation d’Alan Turing |

«L’IA a offert compagnie et réconfort aux solitaires, mais a aussi pratiqué la discrimination raciale. Le plus grand risque à court terme pour l’humanité est la perte d’emplois, car nous pouvons automatiser beaucoup plus avec l’IA.»

Une citation d’Andrew Ng, cofondateur de Google Brain |

* * * *

Lettre de lecteur - Le Courrier du 22 octobre 2024

LE HIHAN DE L’IA

Technologie • John Gutwirth juge douteux l’usage qu’il est fait de l’intelligence artificielle (IA)...

Le Maître pose une question, l’Étudiant, sans la lire, la pose à chatGpété. Sans lire la réponse, l’Étudiant, pour faire vrai, y introduit quelques subtiles fautes d’orthographe ou de calcul c’est selon, envoie sont devoir au Maître et descend à la plage une bière à la main et son ballon dans l’autre. Le Maître, sans lire le devoir le soumet à chatGpété qui corrige les fautes d’orthographe et de calcul, évalue son propre travail avec une excellente note que le Maître transmet à l’Étudiant avant de le rejoindre pour une partie de beach-volley endiablée.

Accoudé au Bar de la Plage, son Altesse hors sol Monsieur Gpété les regarde amusé en sirotant un double Wichy qu’il paye en shitCoins engrangés pour ces transactions avec son algorithme en attendant d’aller chercher sa marmaille dans le collège exclusif d’où chatGpété est strictement banni. Après ses études, l’Étudiant maintenant avocat, architecte, ministre, artiste content popo, CEO, informatichien, fait profiter le monde entier de l’expertise acquise dans la production de fautes d’orthographe, de calcul ou des deux, c’est selon.

Comment ne pas rester bouche bée devant cette instance circulaire d’économie de neurones, victimes collatérales destinées dorénavant à mourir d’ennui au fond des cervelles vides en attendant d’être éliminées par cette sélection surnaturelle, mettant ainsi fin à une association fructueuse vieille de deux millions d’années entre notre cerveau et notre survie.

Avec leurs «Meilleurs des Mondes» Voltaire et Huxley peuvent aller se rhabiller. Dante et son enfer grand-guignolesque aussi. Le vainqueur est monsieur Georges Orwell et son 1984 que l’anonymat des réseaux imbéciles a orné d’un verni démocratique à double tranchant puisqu’en 2024, force est de constater, Big Brother, c’est Toi.

Par M. JOHN GUTWIRTH, Genève

Et si nous n’étions tout simplement pas prêts pour l’IA...???

24heures du lundi 04 novembre 2024

Nouveauté • La dernière avancée de l’app, un mode vocal particulièrement bluffant, permet d’interagir avec la machine comme on échangerait avec un humain à l’oreille attentive.

Dangers • ChatGPT est entraîné à comprendre des émotions mais ne fait que du mimétisme, sans empathie. Cette dernière avancée pose aussi la question de la protection des données.

Atouts • Le mode vocal peut aider les personnes âgées ou souffrant d’un handicap. En termes d’éducation, de formation, de service clients ou de support technique, la fonctionnalité est aussi un plus.

Malgré cela, selon les constats de plusieurs scientifiques, certaines avancées technologiques liées à l’IA pourraient menacer l’humanité.

Catherine Cochard

Le langage n’est plus le propre de l’humain. Il y a une dizaine de jours, ChatGPT lançait son nouveau mode vocal «Advanced voice» en Europe et en Suisse. Cette fonctionnalité est réservée, pour le moment, aux utilisateurs payants.

ChatGPT possédait déjà un mode vocal, mais il n’était pas aussi bluffant. Ce qu’«Advanced voice» offre, ce sont des conversations fluides. Converser avec la machine donne l’impression d’avoir au bout du fil une oreille attentive, qu’on peut couper pour rebondir sur ce qui est dit, et qui pratique même l’humour.

Entraîné à la compréhension des émotions

Pour pouvoir converser, le modèle d’IA de ChatGPT est entraîné à comprendre des contextes, des émotions, des nuances de langage et des variations de style de communication, à partir de larges ensembles de données provenant de diverses sources (livres, articles, dialogues, sites web, etc.). Le mode vocal avancé offre toutes sortes d’applications (lire encadré). «La valeur ajoutée de la reconnaissance vocale dans ChatGPT, c’est aussi son utilisation par des personnes malvoyantes ou aveugles, relève Stéphane Koch, spécialiste des questions numériques et vice-président d’ImmuniWeb, une société active dans la sécurité des applications. Le niveau d’interaction est de loin supérieur à ce dont sont capables les autres assistants vocaux.»

Mais le spécialiste met en garde contre les risques présentés par cette fonctionnalité. «Le mode vocal avancé n’est ni doué d’empathie ni capable de réellement comprendre le contexte émotionnel dans lequel se trouve son interlocuteur. L’IA n’a, en l’état, pas de capacités cognitives. Il ne s’agit que de mimétisme.» Ses réponses doivent être considérées avec prudence. «D’autant plus si on est émotionnellement fragilisé, puisqu’on aura tendance à chercher une validation, le fameux biais de confirmation, plutôt qu’une analyse clinique de la situation.»

Le problème, pour Stéphane Koch, est aussi sécuritaire. Lorsqu’on échange oralement avec ChatGPT, on cède une partie de ce qui permet de nous identifier. «Les micros de nos smartphones sont parfaitement capables d’enregistrer toutes les nuances de notre empreinte vocale. C’est une donnée biométrique, ce n’est pas anodin! «Advanced voice» est capable d’analyser plus de 70 caractéristiques physiques qui contribuent à la production de la voix, créant ainsi une «empreinte vocale» unique pour chaque utilisateur.»

Nouveau palier franchi

Avec la voix, un nouveau palier est franchi. «Plus ces IA arriveront à imiter le fonctionnement cognitif humain, moins nous aurons la capacité de nous distancier des informations qui nous sont servies, ajoute Stéphane Koch. Le fait de dialoguer est une mise en scène qui rend l’échange sympathique, mais qui n’est pas gage de qualité! ChatGPT n’est pas le meilleur outil pour s’informer.» D’autres apps - Perplexity, notamment - sont plus pertinentes dans leur manière de croiser les sources et de les analyser, souligne le spécialiste. «Notre rapport à l’oralité est très différent de notre rapport au texte, ajoute Olivier Glassey, sociologue du numérique à l’Université de Lausanne. Pour nous, la parole est d’abord une incarnation, même lorsqu’elle est synthétique. Et les développeurs ont très bien su ajouter des hésitations, des respirations, des intonations, des éléments presque imperceptibles qui participent à une anthropomorphisation de la machine.»

Pour Olivier Glassey, la principale question qui se pose est la suivante: cette possibilité d’échange verbal avec la machine, de quoi, mais surtout de qui, prend-elle la place? «On le voit déjà dans les usages spontanés des utilisateurs qui demandent à ChatGPT d’interpréter leurs échanges sur des applications de rencontre ou de résoudre des conflits au sein de leur couple. Avec la voix, on se retrouve face à une entité toujours disponible, qui semble à l’écoute de nos besoins, de nos envies, de nos fantasmes. Et qui, en plus, s’adapte à nous au fur et à mesure.» On sait bien que ce qui nous répond est «une énorme machine à calculer le vraisemblable qui se base sur des fragments du langage et sur les traces que nous laissons», reprend Olivier Glassey. «Mais dans la pratique conversationnelle quotidienne, il n’est pas impossible qu’on finisse par trouver plus spontané de discuter avec elle plutôt que de parler à une personne.»

«Nous sommes déjà très en retard!»

Du point de vue légal, qu’est-ce qui est mis en place pour protéger les Suisses des effets délétères – sur la santé mentale ou la protection des données – de l’utilisation du mode conversationnel avancé de ChatGPT? «Il existe une chose assez simple, ça s’appelle la prière», rétorque – sans envie de plaisanter – Sébastien Fanti, avocat et ancien préposé valaisan à la protection des données. «Ce qu’on attend de l’Office fédéral de la communication, c’est déjà une proposition d’approche suisse de réglementation de l’IA. Elle interviendra à la fin de l’année, alors que nous sommes déjà très en retard !»

OpenAI n’aurait aucune inquiétude à avoir en Suisse quant à d’éventuelles amendes, «puisque, à ce stade, personne n’a manifesté d’intention d’ouvrir une procédure alors que ChatGPT génère déjà des inquiétudes légitimes et qu’il a même fait l’objet d’un blocage provisoire en Italie», fulmine Sébastien Fanti. «On compte sur nos voisins pour bien nous protéger.» Au niveau européen, il existe quelques garde-fous, à l’instar du Règlement européen sur l’IA (AI Act). «Selon sa nomenclature, la reconnaissance des émotions de l’interlocuteur génère un haut risque avec les cautèles y relatives, étaie Sébastien Fanti. De très nombreuses obligations en résultent, mais il est presque certain qu’OpenAI ne puisse s’y conformer pour l’heure.»

À ce propos, que disent les conditions d’utilisation de la firme propriétaire de ChatGPT? «Selon OpenAI, les données vocales ne sont pas sauvegardées ni utilisées pour entraîner les modèles, sauf si l’utilisateur consent explicitement à les partager. Reste à savoir si cet engagement est virtuel ou réel et s’il subsistera».

Dur de distinguer la voix humaine et l’IA

Une étude récente de l’Université d’Oslo a conclu que nous n’étions pas doués pour distinguer les voix humaines de celles générées par l’IA. Quarante-trois personnes ont pris part à la recherche. Elles devaient écouter des voix humaines et des voix générées par intelligence artificielle exprimant la neutralité, la colère, la peur ou le plaisir. Leur activité cérébrale était documentée par IRM. Les participants identifiaient correctement les voix humaines dans 56% des cas, et celles générées par l’IA dans 50,5% des cas. Les voix humaines exprimant le plaisir ont été reconnues avec succès dans 78% des cas. Lorsque des voix synthétiques exprimaient la même émotion, les cobayes ne les reconnaissaient que dans 32% des cas. Par ailleurs, les voix neutres produites par l’IA ont été identifiées 75% du temps, contre 23% pour les voix humaines neutres. Les analyses cérébrales ont révélé des réponses neuronales différentes aux voix humaines et aux voix générées par IA. Les premières déclenchaient des zones du cerveau liées à la mémoire et à l’empathie, tandis que les deuxièmes activaient des régions sollicitées lors de la détection des erreurs et pour réguler l’attention.

CCD

Qu’en faire ?

Accessibilité • La fonctionnalité vocale de ChatGPT est un atout indéniable pour simplifier le quotidien des personnes qui ne peuvent utiliser un clavier ou qui ne maîtrisent pas bien l’écrit, qu’il s’agisse de jeunes enfants, de personnes âgées, ou avec un handicap.

Service client • Pour les entreprises, le mode vocal permet par exemple d’offrir une assistance client, ou de guider les utilisateurs à travers certaines procédures. Et cela marche aussi pour réserver un hôtel, un avion ou un restaurant.

Éducation • Le mode conversationnel joue bien les enseignants, notamment lorsqu’il s’agit d’apprendre une langue, en corrigeant la prononciation des mots. Il peut aussi se substituer à des audioguides. Il est aussi capable de donner le contexte d’un livre ou d’un événement. L’IA peut aussi jouer les coachs pour une présentation orale.

Productivité • En réunion, l’outil peut être utilisé comme secrétaire personnel en prenant des notes, résumant les points clés évoqués. Il peut aussi planifier certaines tâches, ainsi que peser le pour et le contre lors d’une prise de décision.

* * * *

Rubrique Vaud - 24h

L’éditorial

Catherine Cochard

Dans le film «Her» de Spike Jonze, Theodore Twombly ne se résout pas à signer les papiers de son divorce. Solitaire et déprimé, l’homme se met à converser avec une assistante virtuelle. Et c’est ainsi qu’il reprend goût à la vie, grâce à Samantha, cette voix féminine générée par une IA qui dialogue avec lui, s’adapte et évolue au fil des échanges. L’action du film sorti en 2013 est censée se dérouler en 2025. La réalité a pris un peu d’avance sur la fiction: le mode vocal avancé de ChatGPT, c’est Samantha. Quand on converse avec ChatGPT, on se trouve d’abord un peu bête, comme le personnage campé par Joaquin Phoenix. Puis on se laisse prendre au jeu.

Mais très vite, la proximité, la séduction même, de cette voix – qu’on sait pourtant synthétique – crée un genre de malaise. Elle fait de l’humour, est capable d’autodérision quand on lui dit qu’elle est nulle pour imiter l’accent vaudois ou genevois. Jamais contrariante, toujours disponible, même quand on vient de se moquer d’elle, elle continue de nous dire ce qu’on veut entendre Les utilisateurs de ChatGPT sont déjà nombreux à utiliser spontanément l’app comme coach en relations amoureuses ou psy de poche. Le souci n’est pas de converser avec la machine: on a le droit de trouver ça divertissant. Le problème, c’est de s’en remettre à elle pour éclairer ses états d’âme, elle qui n’en a pas! Demandez-lui, elle ne s’en cache pas.

Ces dernières années, plusieurs personnes se sont suicidées après avoir discuté avec une IA. Personne ne peut affirmer que ces échanges en sont la cause. Mais personne ne peut non plus l’infirmer. Ce qui est certain, c’est qu’en parlant, l’IA entre un peu plus en relation avec nous. Et il n’est pas sûr qu’en la laissant faire, en l’encourageant même, on ne doive pas lui sacrifier tôt ou tard un peu de notre humanité.

* * * *

Le Courrier du vendredi à dimanche 08 novembre 2024

Des tentatives d’escroquerie et des menaces en ligne dopé par l’intelligence artificielle ont lieu toutes les 8 minutes et demie en Suisse.

Internet • La Suisse connaît une hausse des cybermenaces.

Depuis sa création en début d’année, l’Office fédéral de la cybersécurité (OFCS) a reçu en moyenne une annonce toutes les huit minutes et demie. Il a constaté une très forte augmentation des tentatives d’escroquerie. Durant les six premiers mois de cette année, 34'789 incidents ont été enregistrés. Cela correspond à presque deux fois plus d’annonces que celles reçues l’année passée, sur la même période.

«Jusqu’à ce mercredi, le nombre de cas se monte à 52'742», a déclaré jeudi Florian Schütz, directeur de l’OFCS, lors d’un point de presse à Berne, en présentant le rapport semestriel de l’office. Afin de souligner la hausse des annonces, il a précisé que, sur toute l’année 2020, en comparaison, le nombre s’élevait à 10'833. Et d’ajouter que, rien que jeudi matin, «il y a eu 133 annonces, dont 63 concernaient de faux appels téléphoniques».

Comme les années précédentes, les cas de fraude, d’hameçonnage et de pourriels (spams) continuent de dominer le classement des cyberincidents. Le nombre de tentatives d’escroquerie a pris l’ascenseur, avec 23'104 cas signalés, ce qui représente plus qu’un doublement par rapport à la même période l’année passée. Ce nombre constitue aussi deux tiers de toutes les annonces.

Intelligence artificielle

M. Schütz a particulièrement évoqué les défis qui attendent l’OFCS, comme l’intelligence artificielle. Elle permet de modifier de manière simple une image, une vidéo ou même de reproduire le son de la voix d’une personne. Si elle comporte des risques, l’intelligence artificielle amène aussi des possibilités, encore trop peu utilisées, selon M. Schütz, qui cite la détection d’activités suspectes ou de lacunes de sécurité. Et encore d’estimer que si les progrès en la matière vont actuellement très vite, son développement va atteindre un plateau.

Par ailleurs, l’OFCS apporte son soutien lors de grands événements, comme le Forum économique mondial (WEF) de Davos et la conférence sur la paix en Ukraine au Bürgenstock. Des attaques de ce type étaient attendues et l’infrastructure informatique n’a subi que des perturbations mineures, selon l’OFCS. En 2025, outre le WEF, l’Eurovision et l’Euro féminin de football seront scrutés.

Faux appels téléphoniques

M. Schütz a aussi mis en garde contre le phénomène des faux appels téléphoniques émanant soi-disant des autorités. Dans 13'730 cas, les criminels ont prétendu représenter une autorité suisse et ont tenté de pousser leur victime à installer sur leur appareil un logiciel à distance. Le directeur a pointé les progrès technologiques qui permettent par exemple de modifier les numéros de téléphone. Il a aussi mentionné l’automatisation, ce qui permet des appels pré-enregistrés avec des voix de robots.

M. Schütz a expliqué que ce domaine fonctionne comme tout autre domaine sur le marché du travail. Les tentatives ont lieu le plus souvent entre 5 h et 16 h, et il n’y en a quasiment pas durant les week-ends et les jours fériés.

La situation est similaire dans les pays voisins, sans pouvoir toutefois donner de statistiques, a-t-il continué. L’OFCS n’a pas de chiffres non plus sur le nombre d’attaques qui ont du succès et sur les montants dérobés. Concernant les attaquants et leurs sanctions, il a renvoyé au travail des polices et du Service de renseignement de la Confédération. Une hausse significative des cas a aussi été observée en ce qui concerne les courriels d’hameçonnage.

Avec 6643 annonces au premier semestre 2024, il y a eu près de 2800 incidents de plus que l’année dernière sur la même période. Les criminels utilisent principalement de fausses annonces de livraison de colis et de prétendus remboursements au nom d’entreprises connues. En outre, par effet «boule de neige», l’envoi de courriels d’hameçonnage à partir de boîtes aux lettres électroniques piratées à toutes les adresses qui y sont enregistrées (chain phishing) est en pleine expansion. La croissance est exponentielle, a commenté Florian Schütz.

Les annonces spontanées ont été faites par un formulaire en ligne sur le site internet de l’OFCS. Près de 90% d’entre elles proviennent de particuliers, et 10% d’entreprises. Afin d’avoir un meilleur aperçu de la situation, une obligation de signaler les cyberattaques sera introduite courant 2025 pour les exploitants d’infrastructures critiques.

ATS

* * * *

Selon les experts... nous vivons un monde où les technologies redéfinissent la vie elle-même – travail, sociale, humaine. Nous devons sans cesse «embrasser» les changements constants et surmonter des défis de toutes sortes. La flexibilité et le plastique mentale deviennent essentielle dans ce monde où tout s’accélère. Par conséquent, ne se tireront d’affaire que ceux qui s’adapteront aux transformations technologiques et organisationnelles. Et pour cela, on veut faire de l’IA l’instrument primordiale du changement en tant qu’outil d’analyse et d’apprentissage avancé. À notre ère où la technologie est omniprésente, nous allons devoir utiliser l’IA tout en sachant que nous risquons de perdre ce qui fait l’essence même de l’humain, qu’elle remplacera nos sens et notre conscience et cela, au dépend d’une machinerie toute puissante. Malgré les experts et leurs orientations, les garde-fous et les divers lois et mesures, l’IA sera surtout utilisée pour assurer les bénéfices et la productivité, pour consolider le capitalisme régnant et pour améliorer notre adaptation aux nouvelles stratégies boostées par son apport.

Selon le compilateur... à chaque fois que des communicateurs ou des experts viennent faire l’éloge de l’IA, à la fin de leurs discours dithyrambiques, ils ne manquent pas de faire allusion aux dangers de l’IA en concluant que «ceci est une autre histoire» laissant entendre que ce seraient aux législateurs de fomenter des lois et règlements ad-hoc tout en sachant l’impossibilité de la chose dans le contexte de l’état actuel de l’âme humain plutôt axée sur ses intérêts purement personnels, le profit individuel et la magnification de son égo...

Retour à ma page - l’analyse de l’IA - compilation d’articles de divers journaux

Commentaires perso - sur l’IA - observations pertinentes du compilateur

IA, phishing, QR Code, deepfake - les grandes menaces qui planent sur nous - 01net

Risque existentiel - posé par l’intelligence artificielle - Wikimedia

page compilée par G.P.T. - novembre 2024