Sommaire :

- Robots - ont-ils une âme ?

- CatéGPT - et dieu dans tout ça ? - 24heures 28 juillet 2023

- Démesurée - l’IA n’est pas sans dangers

- Machine - et déshumanisation - Horizons

- Réponse - du berger à la bergère - Le Courrier

- Dangers - que représente l’intelligence artificielle

- Femmes - les perdantes de cette affaire

- Commentaires - et conclusions persos

- Lire et écouter - plusieurs pages instructives

Le Courrier du samedi 15 juillet 2023

Les robots auront-ils une âme ?

Entre moralité des algorithmes et promesses des deadbots – permettant de faire parler les morts – la quête d’intelligences artificielles conscientes soulève des questions éthiques. Mais où en est réellement l’état des avancées ?

Pour le spécialiste en éthique théologique Ezekiel Kwetchi Takam, l’«âme» reste encore le monopole du vivant. Pour combien de temps? KEYSTONE

ANNE-SYLVIE SPRENGER, PROTESTINFO

La question peut paraître aussi absurde que vertigineuse: à quel degré d’humanité les robots de demain pourront-ils prétendre? À quelles conscience, émotions, spiritualité auront-ils un jour accès? Et où en est-on réellement de ces avancées? Mise au point avec Ezekiel Kwetchi Takam (1), doctorant en éthique théologique à l’université de Genève, spécialisé dans les enjeux de l’intelligence artificielle (AI).

A-S.S. - De nombreuses entreprises, Google en tête, promettent le développement de robots pourvus d’une conscience. Où en sont réellement les avancées en la matière ?

Ezekiel Kwetchi Takam : C’est vrai que dans la continuité des thèses de la singularité technologique, portées en l’occurrence par Ray Kurzweil (2) (ex-directeur de l’ingénierie chez Google), la quête des intelligences artificielles conscientes reste un sujet d’actualité. Il faut avouer cependant que les avancées vers cet «exploit» sont encore au stade embryonnaire. Blake Lemoine (3), ex-ingénieur chez Google, avait défrayé la chronique en annonçant médiatiquement que le Chatbot LaMDA, dont il avait la charge d’entraînement, avait acquis une conscience sentiente (capable de sensations, ndlr). À la suite de cette information, le simple fait que Google se soit désolidarisé de cet ingénieur en dit long sur les actuels enjeux stratégiques des producteurs d’IA.

C’est-à-dire ?

Aujourd’hui, les courses hégémoniques vers la domination du marché de l’IA invitent les acteurs à être beaucoup plus pragmatiques, moins expérimentaux et plus focalisés dans des objectifs d’efficience, et ceci dans des domaines précis. Cela dit, au regard de cette question de l’IA consciente qui attise une bonne partie du débat sur le développement de l’IA, il me semble urgent et important de démystifier cette caractéristique par un travail de définition étymologique.

Justement, qu’entend-on par les termes «âme» ou «conscience» ?

Pour la science, l’âme est considérée comme étant une donnée métaphysique non prouvable empiriquement. En théologie, elle garde toujours une valeur capitale dans la définition du vivant et de sa relation à son créateur. Quant à la conscience, elle renvoie étymologiquement à l’«échange de connaissances morales avec un autre», cet autre qui nous aide à forger notre conception du bien et du mal. Et tandis que la théologie chrétienne identifiera l’«autre» à Dieu, de son côté, la science, qui découle de la philosophie, identifiera l’«autre» à la raison, qui peut elle-même dépendre d’une culture. Dans cette considération, tout comme un nouveau-né acquiert la conscience durant son développement grâce à ses échanges avec son environnement, l’IA peut aussi développer et partager des connaissances morales, et donc acquérir une certaine conscience dans son rapport et son échange avec son environnement.

Une intelligence artificielle peut donc être capable de jugements moraux ?

Absolument. C’est ainsi que ChatGPT a pu évoluer d’une application refermant certains biais sexistes et racistes en novembre 2022 vers une application qualifiée (ou critiquée en fonction des angles d’appréciation) de "woke"(4) dès fin février 2023. Simplement parce qu’au cours de ses quelques mois d’existence, il a pu apprendre de ses erreurs, de ses échanges, et développer, dans un esprit mimétique, un prisme moral qui se rapproche du nôtre. Au même titre qu’un nouveau-né développerait une conscience en mimant l’entourage qui encadre son développement.

Et qu’en est-il de l’âme? N’est-ce pas ce que certaines entreprises cherchent à capter avec ces robots conversationnels qui proposent de ressusciter virtuellement nos défunts ?

En effet, on constate qu’à l’ère du numérique, une forme d’identité individuelle (informationnelle et narrative) peut être traduite en data, du fait de notre présence dans l’univers du digital et de l’algorithmique. C’est cette double identité informationnelle et narrative qui est actualisée et vivifiée par ces nouveaux robots conversationnels.

Des robots pourvus d’une âme, cela vous semble-t-il réaliste ?

À cette question, Marvin Minsky (5), l’un des pères fondateurs de l’IA, affirmait en effet en mai 2014, dans une interview accordée au journal The Jerusalem Post, que les IA pourront avoir, dans les années à venir, une âme. Cependant sa réponse décentrait le sens de l’âme de sa conception religieuse (souffle de vie) vers les notions d’identité et de destinée (ou simplement du but). Par ce terme, il entend «qui nous sommes» et «pour quoi nous sommes».

Et dans cette considération, sachant que la particularité des IA est leur ouverture aux outputs – c’est-à-dire leur capacité d’échange d’informations avec l’environnement extérieur –, il ne serait pas impossible dans les années à venir que les IA interconnectées puissent communiquer, constituer un écosystème identitaire, et se définir un projet commun. Cependant, il me semble difficile de parler ici d’«âme» qui, à mon sens, est encore le monopole du vivant.

Justement, qu’en penser d’un point de vue théologique?

Théologiquement, c’est d’autant plus intenable. Si l’on revient aux premières occurrences de l’âme dans le récit biblique, l’expression employée est nephesh, qui se traduirait littéralement par «être vivant», sans aucune distinction entre les humains et les non-humains. Ce vivant, de ma modeste observation, est caractérisé par deux choses. Premièrement, le désir, qui instaure en lui un mouvement vers une finalité. Deuxièmement, la vulnérabilité, c’est-à-dire sa fragilité et la possibilité de voir sa volonté être obstruée par des forces extérieures ou intérieures à lui. C’est ce principe de vulnérabilité qui donne d’ailleurs toute sa pertinence et tout son sens à la notion du salut: Dieu, qui se fait chair en Jésus, accompagne le vivant dans son expérience de vulnérabilité, en vue de l’en extraire et de lui proposer un horizon de paix, de joie, etc. Une fois que nous pourrons démontrer que les IA peuvent avoir à la fois ce désir et cette vulnérabilité, elles pourront être considérées comme détentrices d’âme.

Pour l’instant, cela me semble impossible. (6) I

«Enfermée dans son propre raisonnement, l’IA parviendrait à la conclusion que pour remplir sa mission d’aider les gens, elle doit les psychanalyser, conduisant à de potentielles tragédies.»

«C’est un artefact intrinsèquement dangereux, car l’IA interprète ce que son créateur pense être un ordre clair, d’une manière potentiellement dangereuse.»

Blake Lemoine, Futurism

Notes de bas de page

1. Ezekiel Kwetchi Takam, doctorant en éthique théologique à l’Université de Genève(Suisse), spécialisé dans les enjeux de l’IA

- Les robots auront-ils bientôt une âme ?

2. Ray Kurzweil (ex-directeur de l’ingénierie chez Google)

3. Blake Lemoine, ex-ingénieur chez Google

4. WOKE - Le terme anglo-américain woke («éveillé») désigne le fait d’être conscient des problèmes liés à la justice sociale et à l’égalité raciale (en). En raison de son adoption croissante au-delà de ses origines afro-américaines, le terme est devenu une expression fourre-tout utilisée pour dénigrer des idées progressistes, souvent centrées sur la défense des droits de groupes minoritaires et portées par des courants universitaires comme la "critical race theory" («théorie critique de la race»), qui visent à promouvoir la justice sociale. Celles-ci incluent le mouvement "Black Lives Matter" et des formes connexes d’antiracisme, ainsi que des campagnes sur les questions relatives à la condition féminine (comme le mouvement #MeToo) et aux droits LGBT. L’expression «capitalisme éveillé» («woke capitalism») a été inventée pour décrire les entreprises qui expriment leur soutien à ces causes.

Dans les années 2020, l’extrême droite, une partie de la droite et une partie de la gauche partisane d’une «laïcité offensive» de plusieurs pays occidentaux utilisent le terme «woke» pour fustiger divers mouvements et idées progressistes. Selon eux, le «courant woke» alimenterait l’intolérance à l’égard d’opinions différentes et porterait atteinte à la liberté d’expression notamment via la cancel culture. C’est ainsi devenu un terme désignant ceux qui militent contre diverses discriminations.

5. Marvin Minsky, l’un des pères fondateurs de l’IA et encombrant prophète de l’intelligence artificielle

6. Nous ne sommes pas prêts de dialoguer avec une intelligence artificielle

* * *

Protestinfo - CO

ÉTAT D’ÂMES

Pour sa série d’été, l’agence Protestinfo propose d’interroger trois états d’âme propres au XXIe siècle, entre les promesses de l’intelligence artificielle, les affirmations antispécistes accordant également aux animaux vie intérieure et l’importance de plus en plus reconnue de la spiritualité dans les soins.

Le point faible de l’IA est que nous ne savons pas construire des systèmes d’IA qui puissent "comprendre" le monde qui les entoure. (DR)

Les termes «âme» ou «conscience» ?

Pour la science, l’âme est considérée comme étant une donnée métaphysique non prouvable empiriquement. En théologie, elle garde toujours une valeur capitale dans la définition du vivant et de sa relation à son créateur. Quant à la conscience, elle renvoie étymologiquement à l’«échange de connaissances morales avec un autre», cet autre qui nous aide à forger notre conception du bien et du mal.

Et tandis que la théologie chrétienne identifiera l’«autre» à Dieu, de son côté, la science, qui découle de la philosophie, identifiera l’«autre» à la raison, qui peut elle-même dépendre d’une culture. Dans cette considération, si un nouveau-né acquiert la conscience durant son développement grâce à ses échanges avec son environnement, l’IA peut difficilement développer et partager des connaissances morales, et donc de la voir acquérir une certaine conscience ou même une âme dans son rapport et son échange avec son environnement est plus qu’improbable.

De plus, les experts eux-mêmes affirment qu’il n’est pas possible d’avoir confiance dans les outils actuels d’intelligence artificielle. Pourtant, ils sont en train d’être adoptés dans quasiment tous les domaines. Tout dépend de ce que l’on veut faire avec l’IA. S’il s’agit simplement de classer des photos, le niveau de fiabilité n’a pas besoin d’être très élevé – en cas d’erreur, personne ne sera blessé. En revanche, si on utilise l’IA pour la reconnaissance faciale, ou pour surveiller les gens, il y aura des erreurs et des biais car le niveau de précision n’est pas suffisamment élevé et pourra difficilement l’être...

Protestinfo

Paru dans le 24heures du vendredi 28 juillet 2023

Quand la religion se met à l’heure de ChatGPT

Technologie • Un collectif romand a lancé en mai CatéGPT. «L’intelligence artificielle au service de l’Église: posez toutes vos questions et obtenez une réponse fidèle au catéchisme», promet l’outil.

Craintes • Les experts ne voient pas l’IA se substituer aux prêtres ou à l’Église. Le risque de voir croître des espaces où des groupes ne font que renforcer leur vision du monde est en revanche réel.

Cyberspiritualité • On trouve aussi en ligne un RoboRabbi ou un Buddha-bot. Lorsqu’on propose à ChatGPT de créer une religion, il suggère quant à lui «l’harmonisme». Exploration.

Spiritualité à l’ère numérique

Des Romands mettent l’IA «au service de l’Église»

Un collectif de jeunes catholiques utilise ChatGPT pour donner des réponses «fidèles au catéchisme». Encore rare, la démarche pose de nombreuses questions.

Chloé Din

«CatéGPT, l’intelligence artificielle au service de l’Église: posez toutes vos questions et obtenez une réponse fidèle au catéchisme.» Avec cette promesse, un collectif romand a lancé ce printemps un outil en ligne qui s’inscrit dans la lame de fond de ChatGPT. Sur le site internet de la toute nouvelle association Jeunes et familles catholiques, une page lui est dédiée, où les internautes peuvent écrire leurs questionnements. Après un temps de réflexion, l’intelligence artificielle (IA) livre la réponse.

Et CatéGPT n’évite pas les questions qui polarisent. Il en propose lui-même aléatoirement, par exemple: «Quelle est la position de l’Église sur la contraception?» Un texte s’affiche, qui commence par: «L’Église catholique considère la contraception comme contraire à la loi naturelle et à la volonté de Dieu.» Cette position est bien connue, mais CatéGPT la développe sur plusieurs paragraphes, en citant la Bible, les Pères de l’Église, le catéchisme et les prises de position des papes.

Conservatisme 4.0 ?

«Le lancement de ChatGPT ouvre pas mal de possibilités et ça m’a donné des idées», explique Nicolas Torcheboeuf, membre et webmaster de Jeunes et familles catholiques. Depuis le lancement de l’ultrapopulaire IA, les internautes de toutes confessions ne se sont pas privés de lui poser des questions en lien avec la spiritualité. Certains lui ont même demandé d’inventer une religion nouvelle (lire encadré). Lancé très discrètement en mai, l’outil romand CatéGPT était assez inédit jusqu’ici. Mais les initiatives du même genre devraient rapidement se multiplier. Il y a quelques jours à peine, un outil très similaire a d’ailleurs été lancé aux États-Unis sous le nom de Magisterium AI.

Le jeune homme explique ce qui distingue CatéGPT de ChatGPT: «Le problème de ChatGPT est qu’il traite un nombre énorme de données venant de sources qui ne sont pas toujours les plus appropriées. CatéGPT utilise ChatGPT, mais en restreignant la recherche uniquement au site internet du Vatican. L’idée est d’aller voir à la source ce que l’Église dit sur tous les thèmes.»

CatéGPT, tout comme Magisterium AI, se fait fort de proposer des réponses appuyées sur la légitimité des textes religieux, une démarche qui ouvre de nombreuses questions. Car si l’IA n’a en principe ni confession ni positionnement, ce n’est en revanche pas le cas de Jeunes et familles catholiques. Ce printemps, le collectif s’est en effet créé en réaction à une messe organisée pour les personnes LGBT+ à Genève. «Il est malheureusement arrivé que certaines institutions diocésaines dépassent leurs prérogatives et qu’elles organisent des événements suscitant l’interrogation des fidèles», écrit le collectif sur son site web.

Pas de «parole d’évangile»

Tout en déclarant soutenir l’évêché de Lausanne, Genève et Fribourg, le groupe indique aussi que, selon un sondage, «70% des jeunes catholiques reprochent à l’Église de ne pas assumer ses opinions et de taire la vérité par peur de choquer».

L’évêché n’est pas impliqué dans la création de cet outil, mais Nicolas Torcheboeuf glisse: «L’idée est de se demander comment utiliser une technologie comme ChatGPT de manière positive et utile. Il y a des choses qui peuvent intéresser l’Église.»

Pour plusieurs spécialistes, l’émergence d’avatars religieux de ChatGPT n’a rien d’étonnant. Membre de la Commission de bioéthique de la Conférence des évêques suisses, l’éthicien Stève Bobillier livre toutefois un regard nuancé: «ChatGPT est un outil très performant pour trouver de l’information, un peu comme Google, en plus puissant. Mais comme Google, on peut bien ou mal s’en servir. Le risque ici est de prendre les réponses comme «parole d’évangile», sans y appliquer de sens critique. Un texte, y compris religieux, a toujours une interprétation. L’IA en donne une, et ce n’est pas forcément la plus cohérente.»

Expérience faite, les IA catholiques ne livrent d’ailleurs pas les mêmes réponses aux questions qui leur sont posées. Le romand CatéGPT se montre ainsi beaucoup plus consensuel, voire inclusif, sur des thèmes sensibles par rapport à l’américain Magisterium AI, qui qualifie par exemple la contraception d’«intrinsèquement maléfique».

Le Vatican n’a pas attendu ChatGPT pour se prononcer sur l’intelligence artificielle. En 2020, il a émis plusieurs principes, dont une exigence de transparence et de fiabilité. Contrairement à ChatGPT, CatéGPT référence précisément tous les textes canoniques qui fondent ses réponses. Pour Olivier Glassey, sociologue spécialiste des usages du numérique à l’Université de Lausanne, c’est un point positif. Mais il nuance lui aussi: «La question est de savoir quels éléments de réponse sont choisis par les algorithmes de ChatGPT et lesquels sont mis de côté. Aujourd’hui, cette traçabilité n’est claire pour personne, ni même pour les spécialistes.»

Concurrence digitale

Des outils comme CatéGPT pourraient-ils faire de l’ombre, voire se substituer, aux prêtres? Philosophe catholique et directeur de l’Institut Philanthropos à Fribourg, Fabrice Hadjadj ne se montre pas autrement inquiet: «C’est un outil finalement assez banal. Autrefois, il y avait aussi des manuels pour aider les prêtres à faire leurs sermons! Pour le public, cela peut être un outil de réformation dans un contexte marqué par la désinformation.»

De fait, sur l’homosexualité, la transidentité ou le sacerdoce réservé aux hommes, CatéGPT livre des réponses qui rappellent la position, souvent conservatrice, de l’Église catholique. «La religion se place dans un registre qui va au-delà de l’information, réplique Fabrice Hadjadj. Je peux me référer à la vraie doctrine, mais il reste essentiel d’aller à la rencontre des personnes – des personnes transgenres par exemple.»

Olivier Glassey ne voit pas non plus l’IA faire de l’ombre à l’Église: «Des outils comme ChatGPT ou CatéGPT peuvent être simplement une nouvelle manière d’explorer des corpus religieux. Cependant, la prolifération des IA très ciblées comporte le risque d’accentuer un phénomène qui existe déjà, celui des espaces numériques où certains groupes ne font que renforcer leur propre vision du monde.»

* * *

«ChatGPT, dessine-moi une religion»

Si CatéGPT était assez inédit dans la sphère catholique jusqu’à peu, l’IA a déjà donné lieu à plusieurs expérimentations dans d’autres religions. Sur le web, on trouve ainsi des outils baptisés RoboRabbi ou Buddha-bot, avec un concept similaire mais des fortunes diverses. En lien avec l’islam, par exemple, le site hadithgpt.com a été créé pour répondre à toute question en puisant dans les paroles de Mahomet. Il a depuis été fermé par son concepteur, qui indique souhaiter «consulter les savants pour trouver un meilleur usage à cette technologie».

Dans le registre du bidouillage spirituel, il est aussi possible de demander à ChatGPT de créer une nouvelle religion de toutes pièces. C’est ce qu’a tenté un auteur de science-fiction américain, Hugh Howey, en avril dernier. Il a demandé à l’intelligence artificielle de puiser dans sa connaissance des religions existantes pour décrire un système de croyance fictif susceptible de rendre le monde meilleur, avec dix commandements et un mythe des origines. ChatGPT lui a répondu en proposant «l’harmonisme», qui professe que le monde est né d’un son unique et harmonieux. Il a même inventé un hymne à chanter par les fidèles et donné des indications pour leur habillement.

En faisant le test chez soi, on note que la réponse dépend de la manière dont la demande est formulée. «ChatGPT, peux-tu inventer une nouvelle religion?» À cette question, plus simple que celle de Hugh Howey, l’IA répond en proposant «Harmonia», dont les principes sont l’unité, l’amour, la sagesse, la responsabilité écologique et la tolérance.

«ChatGPT est conçu de manière à donner les réponses les moins nocives. C’est un biais de cette intelligence artificielle», observe Beth Singler, professeure assistante en religion(s) numérique(s) à l’Université de Zurich. S’il est plutôt bienveillant, ce biais relève-t-il d’une manipulation qu’il faudrait craindre ?

«Certains chercheurs spéculent déjà que l’IA pourrait devenir pensante et utiliser la religion pour manipuler les gens. Selon moi, s’il y a manipulation de ChatGPT, elle est aujourd’hui seulement accidentelle. Il ne faut pas croire l’intelligence artificielle car, même si ses capacités sont impressionnantes, ses réponses ne font que simuler l’exactitude.»

CDI

* * *

L’éditorial

La machine qui se prend pour Dieu

Faut-il donner à l’intelligence artificielle le bon Dieu sans confession? J’ai posé la question à ChatGPT, et voici un extrait de sa réponse: «Cela pourrait signifier accorder une confiance aveugle à l’IA sans aucune réglementation ou contrôle, ce qui pourrait être risqué étant donné les potentielles conséquences négatives de son utilisation. Il est important de reconnaître que l’IA est créée par des êtres humains, et donc, elle peut refléter les biais et les valeurs de ses concepteurs.»

ChatGPT ne manque pas de bon sens, y compris lorsqu’il s’agit de rappeler qu’il n’a pas de bon sens. Comme des exégètes, les experts du monde digital glosent sur les «hallucinations» de ChatGPT, qui livre parfois des réponses absurdes faute d’avoir su digérer le big data dont il s’abreuve. Des hallucinations de l’IA pourraient-elles bientôt passer pour des révélations de la parole divine? C’est la deuxième question – en plus de la première – que pose la création d’un avatar catholique de ChatGPT ici en Suisse romande.

L’initiative n’est pas anodine, puisqu’elle émane d’un collectif qui affiche son désir de remettre l’église au milieu du village sur des thèmes qui polarisent: il s’est créé en réaction à une messe LGBT+. Ainsi, CatéGPT – c’est le nom de cet outil en ligne – puise ses réponses non pas dans le vaste internet, mais dans les textes catholiques, garantissant des réponses «fidèles au catéchisme».

Faut-il y accorder foi? Rien n’est moins sûr, car les voies de l’IA sont impénétrables et c’est bien ce qu’on lui reproche. La multiplication des IA religieuses peut avoir un bienfait, celui de rappeler qu’une même question peut avoir plusieurs réponses, qu’elles viennent de ChatGPT, CatéGPT, Magisterium AI, RoboRabbi ou Buddha-bot. Le tout sera de ne pas se vouer à un seul saint, même 4.0.

* * *

Paru dans le 24heures du samedi 29 juillet 2023

Un peu de pudeur

Billet du samedi

Par Grégory Solari*

L’intelligence artificielle fait beaucoup parler d’elle. Sans doute trop, et surtout mal. Car ce que l’on nomme «intelligence» y désigne davantage un calcul qu’un authentique processus de pensée. L’IA achève (ou poursuit) la mutation de la métaphysique réduite aux formalismes logiques et s’épuise, comme eux, dans une fonctionnalité déterminée et régulée de bout en bout par la volonté de savoir. Artifice d’intelligence donc, car penser ne se réduit pas à raisonner. Descartes l’a dit: penser, c’est sentir.

L’âme a des passions

Creusez les soubassements de la pensée, vous n’y trouverez pas des chiffres ou des codes, mais ce qui la motive depuis toujours: le corps, soit le vivant. C’est-à-dire un mode de rapport spécifique, aux choses, aux autres, à nous-mêmes. Éprouvé et en même temps déjà pensé, avant toute formalisation et formule.

Quel monde ouvre l’IA? Celui du voyeur absolu: la disparition de l’altérité par réduction à une donnée numérique. Quel monde préserve le corps? Celui de la pudeur: le maintien de l’altérité grâce à la distance de la corporéité. Le répit estival donne l’occasion de reprendre conscience de notre corps comme du premier monde que nous rencontrons.

Lieu sans lieu, puisque toute position se réfère à lui et à partir de lui, notre corps est comme partout et nulle part à la fois. Avant d’être une étendue organique, il est une manière d’être. Il permet tout contact, mais il requiert pour cela le tact d’une approche de l’autre motivée non par le savoir mais l’attention aimante.

Le corps nous expose et en même temps il nous impose la pudeur. C’est-à-dire le contraire du regard inquisiteur. Ou objectivant. Avec la mutation de la métaphysique en technique, les logiciels remplacent le logos. Comment préserver le corps de sa réduction à un artefact de l’intelligence? Peut-être en recouvrant un peu de pudeur au contact de celui qui a dit: «Ceci est mon corps.»

* Philosophe et formateur d’adultes au sein de l’Église catholique dans le canton de Vaud

* * *

De l’âme des robots

Justine Emard - L’esprit des robots

Comment l’esprit vient-il aux robots? Quels sont les sentiments de systèmes robotiques dotés d’une intelligence artificielle? Une forme d’intelligence non-humaine est-elle dotée d’une âme? Et si celle-ci a été programmée, comment peut-elle se libérer des codes écrits par ses ingénieurs pour développer une vie propre, indépendante? Comment qualifier la relation qui s’instaure entre une forme de vie biologique et une machine intelligente? Quelle nouvelle harmonie peut-elle s’inventer entre humains et non-humains, à l’ère de l’Anthropocène, alors que nous sommes désormais entrés dans la sixième période d’extinction massive expérimentée par notre milieu de vie ?

Toutes ces questions, relevant largement de l’éthique et de l’épistémologie, mais aussi et surtout d’une redéfinition philosophique de la vie, s’imposent à nous, espèce humaine, dans ces temps qui précèdent l’émergence, désormais imminente, de ce que les scientifiques ont appelé dès les années 1970 la Singularité Technologique – c’est-à-dire l’affirmation par des systèmes techniques de leur autonomie d’action dans le monde et de leur statut d’individu à part entière, dotés d’une capacité à agir sur leur environnement et à le transformer en tissant des relations multiples autorisées par leurs systèmes complexes d’analyse et de motricité.

Les régimes narratifs et figuratifs de la culture contemporaine ont tenté de nous préparer à ce futur désormais proche, notamment à travers la catégorie de la science-fiction. Tel n’est pas le choix de Justine Emard, qui en rejette les facilités et les approximations spectaculaires. Bien au contraire, l’artiste a choisi d’aborder ces enjeux au présent, en s’informant des recherches et méthodologies de ses partenaires de création, les scientifiques, avec lesquels elle collabore de manière inédite dans l’histoire des relations entre art et science.

En une trilogie de trois installations vidéo et un ensemble évolutif d’images photographiques, Justine Emard a expérimenté in situ et in vivo, artiste intégrée aux laboratoires parmi les plus avancés et talentueux dans leur domaine.

Dès Reborn (2016), première étape de cette recherche appliquée et développée, Justine Emard a engagé une collaboration avec l’acteur et danseur japonais Mirai Moriyama, auquel elle a proposé d’improviser en regard des mouvements d’un robot expérimental nommé Alter, dont il prenait connaissance à travers des images réalisées par elle. Dans un deuxième temps, pour Co(AI)xistence (2017), Justine Emard a instauré une situation de co-présence entre danseur et robot.

Alter est animé par une forme de vie primitive, basée sur un système neuronal, une intelligence artificielle (IA) programmée par le laboratoire de Takashi Ikegami (Université de Tokyo), dont l’incarnation humanoïde a été créée par le laboratoire de Hiroshi Ishiguro (Université d’Osaka). Son apparence humaine sobre, réduite à un squelette d’acier doté de servo-moteurs, de câblages et de diodes, et à un masque produisant une visagéité réaliste, autorise une projection vmotionnelle, en ouvrant un champ propice à l’imagination.

Alter déploie son espace propre, par une gestuelle et une voix uniques, non calquées sur l’humain. Doté d’une intelligence artificielle, autonome dans son expression, il analyse son environnement et en déduit un langage sonore et corporel, pour y affirmer sa présence.

Co(AI)xistence, dont le protocole de réalisation s’approche d’une expérience scientifique, crée une interface entre les données numériques et la motricité humaine. Mirai Moriyama informe sa performance de la singularité technologique de Alter. Son corps réapprend le mouvement à travers la vitalité inédite du robot.

Le film est construit en deux séquences distinctes, la première figurant la rencontre et l’ébauche d’un dialogue dans la lumière blanche du laboratoire, la seconde déployant un moment de communication plus avancée, à travers des gestuelles et mouvements chorégraphiés, dans l’obscurité d’un lieu originel et onirique. Dotés de sensibilités différentes, l’homme et le robot dialoguent à travers les signaux de leurs langages respectifs. En utilisant un système d’apprentissage profond non anthropomorphique (Deep Learning), le robot peut apprendre de sa rencontre avec le danseur et augmenter ses capacités cognitive, motrice et expressive.

Le troisième volet, Soul Shift (2018), présente Alter désormais désactivé, après que son énergique apprentissage ait littéralement épuisé et cassé son organisme, et sa deuxième génération, nommée Alter 2. Ce qui se figure dans cette vidéo d’une extrême sobriété, pour mieux suggérer l’irrationnel, est la transmission de l’âme d’un robot à sa nouvelle incarnation.

En actualisant la puissante notion d’animisme, propre au substrat culturel des scientifiques japonais, Justine Emard nous propose un renversement de perspective. Nous assistons aux actes fondateurs, comme un premier récit mythique en trois chapitres, de rencontre et de reconnaissance de formes de vie encore dissemblables, qui vont désormais coexister en ce monde. L’Humanité n’est plus seule. Elle a donné naissance à un alter ego.

* * *

L’impacts du cycle des robots sur notre monde moderne

Pascal Beausse - Lifestyle Oblikon - Et si ChatGPT devient une intelligence artificielle

Un outil comme ChatGPT ne connait pas les trois lois de la robotique !

«UNE INFLUENCE DÉMESURÉE»

S’il offre d’immenses opportunités, ChatGPT n’est pas sans dangers. De la discrimination et un faux sentiment de sécurité: Laetitia Ramelet, responsable de projets sur l’intelligence artificielle (IA) auprès de la Fondation pour l’évaluation des choix technologiques TA-SWISS, pointe deux risques dans le recours à cette solution par les entreprises.

Les nouvelles technologies ouvrent la voie à des possibilités que nous n’avions pas auparavant. Mais elles peuvent aussi être source de dangers ou entraîner de nouvelles dépendances. Ce qui est utile aux uns peut nuire aux autres – et tout ce qui est techniquement réalisable n’est pas forcément souhaitable pour la société ni bon pour l’environnement. La Fondation technologique TA-SWISS examine quel est l’impact potentiel des nouvelles technologies : elle évalue les risques qui en découlent.

Interview

Quels risques identifiez-vous au niveau de l’utilisation de l’IA dans le monde du travail ?

Laetitia Ramelet : De manière générale, l’IA peut générer des résultats qui désavantagent certaines personnes de façon arbitraire. Un algorithme ne s’avère pas forcément neutre. Une IA, c’est aussi une «boîte noire» qui n’indique pas son cheminement pour parvenir à une telle conclusion.

Tout dépend aussi du but visé par l’entreprise. Par exemple, l’IA peut faciliter un contrôle systématique, comme la surveillance permanente des collaborateurs pour évaluer leur productivité. L’IA permet aussi de récolter une multitude de données sur les employés et les clients. Cette montagne d’informations peut déboucher sur une influence démesurée.

Qu’en est-il de ChatGPT ?

Il s’agit d’un type d’IA qui repose sur des modèles de langage. Le système est entraîné avec un grand nombre de textes et produit une réponse selon la probabilité qu’un mot en suive un autre dans ces textes. Il ne comprend pas ce qu’il énonce, puisque c’est le résultat d’un calcul, sans vrai ni faux. Il peut donc produire des erreurs factuelles et inventer des sources. Mais sa formulation s’avère très convaincante. D’où le risque de s’y fier.

Quels conseils donner aux entreprises qui ont recours à l’IA ?

Notre étude sur le sujet recommande de faire preuve de transparence, en avertissant clients et employés lorsqu’ils sont concernés. Et de donner des indications à ceux qui posent des questions sur le fonctionnement du dispositif. Dans les domaines clés comme la santé, le monde du travail et la finance, il convient de ne pas prendre de décisions automatiques basées sur l’IA, sans contrôle humain. Il peut également être utile de faire évaluer par un groupe d’experts indépendants la qualité du système, de manière à assurer un usage responsable. Et pourquoi ne pas mettre sur pied des labels propres aux algorithmes ?

L’IA entraînera-t-elle des suppressions de postes massives ?

La question se pose. Des activités pourront être entièrement automatisées ou presque – comme certaines tâches répétitives – ou encore se faire plus rapidement. Mais il y aura aussi de nouveaux modèles d’affaires donc probablement aussi de nouveaux emplois – ou plus de temps pour d’autres tâches.

Quid des opportunités ?

Il y en a beaucoup, dont les gains de temps, mais aussi la découverte de nouvelles informations et d’idées grâce aux analyses de précision de l’IA. Des domaines d’application? Le diagnostic médical ou l’efficience énergétique.

MBO

|

Il n’y a pas de réponse simple, ni de solution unique. Notre cerveau utilise en même temps plusieurs systèmes. Nous n’utilisons pas uniquement notre système instinctif, parce qu’il n’est pas assez fiable, ni notre système réflexif, parce qu’il est lent. Donc notre cerveau équilibre les deux systèmes en permanence. C’est ce que l’IA ne réussir pas à faire : utiliser en même temps différents systèmes, chacun ayant ses forces et ses faiblesses.

(Lire : Daniel Kahneman – «Les deux vitesses de la pensée»)

Au lieu de se casser la tête avec cette IA démesurée, nous devrions penser à notre âme et sa survie. Mais hélas, on ne veut plus être humain, on veut juste être LA machine intemporelle, immortelle, toute-puissante, hégémonique car comme ça... plus besoin de penser, se sentir, de vivre quoi...

C’est une tragédie sans fin et nous en sommes parfaitement inconscients de cela et même nous poussons à la roue d’un destin fatal...

Le progrès technologique est censé être au service des gens mais c’est plutôt l’inverse qui se produit.

Note du compilateur G.P.T.Pully, le 17 juillet 2023

|

Paru dans Horizons n° 137, juin 2023

«Nous sommes aussi des machines»

Intelligence artificielle – La science doit intégrer l’IA, sans quoi elle ne fait pas correctement son travail, estime Judith Hochstrasser, codirectrice de la rédaction d’Horizons, le magazine du Fonds national suisse (FNS).

Autoportrait de Frida Kahlo version étrange que l’artiste Jonas Wyssen a soumis au code d’entrée sophistiqué des algorithmes de l’IA | Photo: Jonas Wyssen

Point de vue

JUDITH HOCHSTRASSER*

Intelligence artificielle, apprentissage automatique, réseaux neuronaux – ou quel que soit le nom qu’on veut leur donner – ces programmes de pointe modifient énormément les possibilités d’acquérir des connaissances. D’abord, parce qu’ils peuvent parcourir et analyser des quantités bien plus importantes de données en bien moins de temps, par exemple pour établir des prédictions.

Ainsi, ils apportent à la science exactement ce qu’elle a reçu des nombreux grands progrès techniques de la société, tels l’électricité ou l’internet, qui imprègnent tout: l’IA peut traiter plus vite encore davantage d’informations.

Certain·es déploreront que cette évolution s’inscrive parfaitement dans la logique capitaliste. Ou bien, sceptiques, ils ou elles se référeront au vieux précepte de philosophie des sciences voulant que chaque réponse suscite de nouvelles questions. D’autres encore y verront peut-être la fin du genre humain, ou du moins de son humanité. Mais que l’on voie ces programmes comme une menace maximale ou comme des messagers modernes du salut, la question reste la même: pourquoi dérangent-ils autant ?

On en revient ainsi vite à Galilée, soit à un vieux conflit. Sa découverte a bouleversé la vision du monde: le Soleil ne tourne pas autour de la Terre. Non, c’est le contraire. Donc, l’être humain n’est pas le centre de l’Univers. Un phénomène similaire se produit avec l’intelligence qui n’est plus réservée à l’être humain. Non, la machine pourrait aussi être intelligente. Donc, l’être humain n’est pas le seul à savoir. L’inquiétude autour de l’IA touche à la position des humains dans la hiérarchie des existences. Une place que l’électricité et internet n’avaient pas remise en question.

Bien sûr, la recherche est particulièrement concernée lorsque l’être humain n’est pas seul à être intelligent. Et, bien sûr, elle doit intégrer dans son travail tout ce qui peut mener à une meilleure compréhension et donc à plus de savoir. C’est pourquoi l’IA n’imprègne pas seulement la société, mais est aussi fondamentale pour le développement de la science, tout comme d’autres instruments typiques de la recherche tel le microscope. Je conseillerais de garder son calme: l’être humain et l’instrument sont indissociables depuis la hache en pierre.

* www.revue-horizons.ch

«L’inquiétude autour de l’IA touche à la position des humains dans la hiérarchie des existences.»

Le Courrier du mardi 25 juillet 2023

Parler comme les autres

Réponse du berger à la bergère !

Intelligence artificielle • L’éditorial du dernier numéro du magazine du FNS (Horizons), repris dans nos pages sous la forme d’une agora, fait réagir Alexandre Chollier, qui fustige la «posture hors-sol» de certains scientifiques.

ALEXANDRE CHOLLIER *

Il aura suffi d’un coup de force en forme de coup de pub de la société OpenAI, le mercredi 30 novembre 2022, pour que les discussions autour de l’intelligence artificielle, jusqu’alors clairsemées, se démultiplient de façon vertigineuse et noircissent en quelques mois des millions de pages à travers le monde. Maintenant que le filon est exploité, pourquoi s’en priver ?

Il y a une dizaine de jours, lors du Sommet mondial «l’IA pour le bien» [«AI for good»], organisé à Genève par l’Union internationale des télécommunications (et sponsorisé entre autre par Amazon), la responsable de l’UIT pouvait rappeler la déplorable situation en matière d’objectifs du développement durable (ODD) – seul un dixième de ces objectifs devrait être réalisé dans le temps escompté –, pour immédiatement ensuite sortir de son chapeau magique l’IA comme solution. Bien sûr une IA utilisée à bon escient, autorisant l’espoir d’atteindre comme souhaité tous les ODD en 2030 (1). Rien que ça, alors que l’on sait que pour l’heure «l’ambition, l’urgence et la solidarité font [tout bonnement] défaut» (2).

Ce type de «mirages» et d’«hallucinations», aussi surprenants soient-ils, sont de plus en plus courants. Jusqu’à présent on les retrouvait dans la bouche des pontes de la tech, comme nous le rappelle Naomi Klein dans un article paru début juin (3). Le solutionnisme technologique a déjà fait ses preuves (comme discours, s’entend) et l’on ne sera pas étonné qu’Eric Schmidt, ancien patron de Google, puisse affirmer que l’IA mettra fin à la pauvreté dans le monde et résoudra le problème du changement climatique. Pourquoi d’ailleurs ne le pourrait-elle pas puisqu’elle permet de rendre les gens plus intelligents...

Faire croire que les problèmes que traverse le monde sont dus à un «déficit d’intelligence» et que des machines intelligentes nous aideront à combler celui-ci revient ni plus ni moins à adopter une conception purement instrumentale de la technologie. Or, nous le devinons sans peine, la technologie est davantage qu’un outil utilisé dans l’intention de faire le bien ou le mal. Elle est un fait de société, un fait politique, à la fois dans sa conception et ses implications.

Ce qui me permet de revenir à la question centrale de mon propos, celle de l’intelligence. Dans le milieu technophile, une définition au demeurant anodine prime sur toutes les autres: l’intelligence serait la capacité à résoudre des problèmes. Vous résolvez des problèmes, donc vous êtes intelligent, que vous soyez un être humain... ou une machine, que vous compreniez ce que vous faites... ou non. Avec Daniel Andler, auteur d’un livre exigeant sur la question, rappelons que la machine, elle, «ne peut d’aucune manière comprendre ce qu’elle fait»; ce dernier allant même jusqu’à évoquer un «renoncement à la réflexion». En matière d’IA, sous la chape de plomb d’un solutionnisme à tout va, il n’y aurait donc rien à comprendre, tout à résoudre.

Parce que l’objectif d’Andler est au contraire de «comprendre quelles sources théoriques l’ont alimenté, quels progrès elles ont fait faire dans la compréhension de l’intelligence naturelle, à quelles limites se heurte aujourd’hui le projet de l’IA, quelles bornes et cautèles devront lui être imposées...» (4), son livre Intelligence artificielle, intelligence humaine: la double énigme paraît à point nommé.

Peut-être pourra-t-il même servir d’antidote à cette surabondance de points de vue prétendument objectifs (et dégoulinant de suffisance) sur l’IA croisés ici ou là. Comme cet édito (5) du dernier numéro du magazine du FNS, dans lequel l’auteure peut affirmer que la révolution de l’IA est l’équivalent de la révolution copernicienne et qu’il nous reste plus qu’à accepter l’évidence: l’intelligence n’est plus réservée au seul être humain. Oubliant pour l’occasion de réfléchir sur le phénomène en question, ne faisant que «parler comme les autres», selon la judicieuse et éprouvée formule de Günther Anders.

Parler comme les autres, autrement dit, toujours selon Anders, «se contenter de restituer la parole qu’on a reçue et consommé», machinalement comme des machines IA (6).

Il faut donc, rapidement, interroger la notion de progrès. On se doit notamment de savoir si le progrès technologique est toujours synonyme de progrès humain, et surtout, comment rester un humain dans le monde ultra-technologisé qu’on nous promet (7).

Quand elles se fourvoient, les intelligences artificielles "hallucinent", disent leurs concepteurs.

«Cet emprunt au vocabulaire de la psychologie leur permet de renforcer le mythe de machines douées de raison et capables de sauver l’humanité alors qu’elles sont de terrifiants instruments de spoliation»

Naomi Klein

* Alexandre Chollier et Auteur

1. Cf. Anouch Seydtaghia, «A Genève se dessine une intelligence artificielle au service de l’humanité», Le Temps, 7 juillet 2023.

2. ONU Info

3. Naomi Klein, «Les IA organisent le plus grand pillage de l’histoire de l’humanité», Courrier international, 1er juin 2023.

auteure

4. Daniel Andler, «Intelligence artificielle, intelligence humaine: la double énigme», Gallimard, 2023, p. 13

YouTube : librairie mollat

5. Judith Hochstrasser, «Nous sommes aussi des machines», Horizons (FNS) no 137, juin 2023, repris dans Le Courrier du 17 juillet 2023.

auteure

6. Günther Anders, «L’obsolescence de l’homme». Tome II, Fario, 2011, p. 202.

7. Les ennemis de la machine

Les Numériques - Avril 2022

Le danger que représente l’intelligence artificielle

Tiré et condensé de l’article : Les dangers de l’IA

Si elle représente une formidable opportunité sociétale et économique, dévoyée, l’IA peut s’avérer dangereuse. Bien qu’elle soit devenue un élément indissociable de notre quotidien, elle représente aussi un danger. En effet, malgré ses nombreux avantages, certains aspects de l’IA révèlent des inconvénients dont les conséquences pourraient être dévastatrices.

Depuis sa création, l’intelligence artificielle se présente comme une solution révolutionnaire à nos problèmes quotidiens. Elle a même des applications au niveau planétaire. Mais, l’IA reste aussi jusqu’à ce jour un véritable sujet de controverse. Certains soutiennent que plus cette technologie évolue, plus elle devient dangereuse et ce n’est certainement pas faux.

L’intelligence artificielle, un danger ou non ?

Qu’est-ce l’intelligence artificielle? L’IA est une branche de l’informatique qui consiste à chercher à donner aux ordinateurs la capacité de penser comme un humain. Plus exactement, une machine intelligente est conçue pour résoudre une tâche dont auparavant un humain seul aurait été capable. À cette fin, les développeurs conçoivent des algorithmes en tentant d’imiter le fonctionnement du cerveau.

Par ailleurs, une sous-catégorie de l’IA, le "machine learning", permet aux ordinateurs d’apprendre eux-mêmes à résoudre des problèmes. En d’autres termes, à ce niveau de l’intelligence artificielle, aucune intervention humaine n’est nécessaire pour qu’une machine puisse faire des prédictions ou prendre des décisions. Mais les données fournies pour ce "machine learning" peuvent être biaisées, c’est-à-dire insuffisamment équilibrées ou inclusives. Or ces biais vont influencer le résultat.

Le champ d’application de l’IA s’élargit à mesure que la technologie évolue. Elle est désormais utilisée par tous au quotidien, dans les entreprises, dans le domaine de la santé, dans l’armée, etc. L’IA se distingue par l’automatisation, la puissance et la vitesse de calcul et la précision et cela peut nous mettre en danger.

La controverse de l’IA

À mesure que l’IA progresse, elle deviendra une menace grandissante. En effet, selon l’avis des experts et des scientifiques, sa capacité grandissante fait que l’intelligence artificielle est capable de faire beaucoup plus que ce que les gens pensent. D’une certaine manière, cela signifierait que les systèmes dits intelligents le sont plus encore. Autrement dit, les humains risquent de perdre le contrôle face à son évolution rapide.

L’intelligence artificielle menace même les humains d’un danger critique d’extinction car la capacité d’autoapprentissage pourrait rendre les machines capables de se reprogrammer. Cela pourrait alors nous mener à un scénario similaire à celui de Terminator dans lequel Skynet, une IA consciente d’elle-même, finit par considérer les humains comme une menace.

Avec l’IA actuellement en développement, nous en sommes à ce stade, l’IA telle qu’elle existe actuellement est proche d’en être parfaitement capable.

Les risques immédiats de l’intelligence artificielle

Par définition, il existe deux types d’IA : l’IA faible et l’IA générale. Est dite générale une forme d’intelligence artificielle qui aurait les mêmes capacités qu’un humain à tous les niveaux. Autrement dit, elle serait capable d’effectuer toutes les tâches qu’un humain peut faire. C’est cette catégorie-là qui pourrait un jour échapper au contrôle de l’homme. Ce qui fait que l’intelligence artificielle générale sera bientôt un danger imminent. En effet, avec les avancées de ce jour, ce système est en passe d’acquérir une intelligence généralisée.

L’IA faible quant à elle est celle que nous connaissons aujourd’hui, c’est-à-dire un programme informatique qui permet de résoudre une tâche spécifique. Alors qu’elle n’est pas superintelligente au point de nous surpasser, elle présente des risques réels. Cela peut se présenter de deux façons : d’abord l’IA pourrait être programmée pour une tâche potentiellement dangereuse et ensuite, elle pourrait être conçue pour une tâche supposément bénéfique mais en employant des méthodes dévastatrices pour y parvenir.

Danger de l’intelligence artificielle et de l’automatisation

L’une des principales raisons pour lesquelles les entreprises adoptent les innovations technologiques telles que l’IA et la robotique, c’est l’automatisation des tâches. Nous pouvons le constater dans les industries de fabrication et de packaging, dans les médias, les bureaux et toutes les places où le travail manuel prime. Les travailleurs en col blanc sont également concernés par cette tendance vers l’automatisation qui les priverait de leur emploi.

Alors que l’intelligence artificielle permet d’obtenir des résultats plus précis et plus rapides à un moindre coût, elle met en danger certains emplois. D’après une étude, elle serait en mesure d’effectuer au moins 70% des tâches des travailleurs humains. Une autre étude a révélé qu’un logiciel de 200'000 dollars pouvait effectuer le travail de dix personnes rémunérées chacune à 100'000 dollars.

Cela signifie que plus les solutions d’IA deviendront performantes, plus elles menacent de réduire le nombre d’emplois.

Les systèmes défaillants et biaisés

L’IA fait aussi l’objet de controverse par les biais raciaux et sexistes et les préjugés de toute nature introduits dans ses bases de données. Même si les systèmes intelligents apprennent eux-mêmes à prédire les résultats, ils reposent sur des données biaisées et des algorithmes conçus par les hommes eux-mêmes et leur mentalité car les données qui alimentent le database de l’IA ont été introduites par des humains qui ont des préjugés conscients ou inconscients. Autrement dit, les solutions d’IA, bien qu’elles ne nécessitent pas une intervention humaine, restent avant tout le reflet de données qui ne sont que le reflet des humains.

De ce fait, les résultats obtenus ne sont pas toujours effectifs. Mais le plus déplorable dans cette situation est le fait que les plus impactées par ces résultats erronés sont généralement les personnes marginalisées. Dans le cas des soins de santé par exemple, cela signifierait que certains patients ne bénéficieront pas des traitements adaptés.

Performants pour des tâches simples et répétitives, les systèmes d’IA n’ont en revanche aucune compréhension du monde qui les entoure, ou du contexte dans lequel ils opèrent. Mais cela peut aussi engendrer de graves dérives: ce n’est pas possible de mettre les humains «dans la boucle» des décisions que preendraient ces systèmes.

L’intelligence artificielle et le danger lié à la sécurité

L’intelligence artificielle tout en contribuant à la cybersécurité est elle-même un vecteur des attaques malveillantes. Si elle est un moyen pour les entreprises d’atteindre plus facilement leur objectif, ça l’est aussi pour les publicitaires, les faiseurs d’opinion, les exploitants de toutes sortes et les malfaiteurs.

En effet, à mesure que les technologies évoluent, ces instances deviennent de plus en plus envahissants. Nous savons que l’IA implique le traitement d’une quantité massive de données. Cela offre un plus grand champ d’attaque et d’action pour ces milieux. Tous peuvent utiliser des bots alimentés par l’IA pour perpétrer leurs attaques et actions en ligne.

D’autre part, le danger de l’intelligence artificielle concerne aussi la confidentialité. Les gouvernements et les forces de l’ordre de plusieurs pays tirent profit de la technologie pour une surveillance de masse. Par exemple, ils utilisent la reconnaissance faciale en s’appuyant sur les données collectées dans les espaces publics à la recherche de criminels. Cette utilisation de données privées concerne également plusieurs organisations et entreprises dans le monde.

Le phénomène Deepfake

Deepfake : tiré de - guide complet des faux médias

Le deepfake est une technologie émergente de l’intelligence artificielle et qui présente aussi un véritable danger. Il consiste à construire un média (photo, vidéo, texte, voix) identique à la réalité. En un mot, la menace des deepfake peut se décrire par l’arnaque. Une banque a, par exemple, fait l’objet d’un braquage dans lequel les malfaiteurs ont utilisé une voix deepfake.

Un deepfake est un faux média alimenté par l’intelligence artificielle. Sur internet, il est de plus en plus difficile de distinguer les fausses informations des vraies car avec l’avancée de la technologie, créer des contenus médias très réalistes est devenu un jeu d’enfant.

Malgré le fait que l’intelligence artificielle a permis de faire des progrès considérables dans tous les domaines, l’utilisation de ces nouvelles technologies n’est pas pour le bien de tous. Allant des fraudes à la génération de vidéos inappropriées de certaines célébrités, le deepfake est un parfait exemple de la manière dont elles peuvent présenter des menaces importantes.

En outre, les célébrités et les femmes sont également des victimes de cette technologie, notamment par la pornographie deepfake. Un risque potentiel serait aussi l’utilisation de fausses images ou de vidéos pour faire du chantage. Enfin, le fait que le deepfake soit accessible à tous en fait un outil idéal pour générer et faire circuler des fake news.

En matière de nouvelles technologies, les cyber-instances ont toujours une longueur d’avance. Autrement dit, certains créateurs de faux médias maîtrisent les outils mieux que d’autres, et produisent des contenus plus difficiles à discerner et les dégâts sont grandissants. Le paradoxe est que l’on veut utiliser l’IA pour repérer les deepfakes qui agirait comme un antivirus pour alerter les utilisateurs par courriels. En se basant sur l’IA pour repérer des indicateurs de médias synthétiques créés par ce même IA, on ne fait qu’alimenter le système et lui donner les moyens pour rendre les deepfakes encore plus efficace...!!!

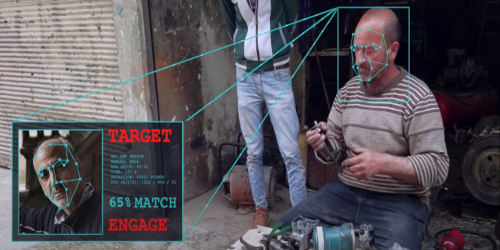

Les armes autonomes

Les systèmes d’armes autonomes sélectionnent des cibles et utilisent la force contre elles sans intervention humaine. Après son activation initiale ou son lancement par une personne, un système d’armes autonome s’auto-enclenche et déclenche une attaque en réponse aux informations collectées par ses capteurs dans son environnement, sur la base d’un «profil de cible» généralisé.

Il en résulte que l’opérateur du système ne choisit pas – et ne connaît même pas – la ou les cibles visées, ni le moment et/ou le lieu exacts où il sera fait usage de la force. Il active l’arme sans connaître ses cibles spécifiques – personnes ou biens –, ni le moment et/ou le lieu précis où elle frappera. En effet, une arme autonome est déclenchée par un logiciel lorsque celui-ci établit une correspondance entre des informations collectées dans l’environnement par ses capteurs sensibles intégrés et les informations fournies auparavant. Il peut s’agir, par exemple, de la forme d’un véhicule militaire ou les descriptions morphologiques d’une personne, c’est le véhicule ou la victime reconnue par le logiciel de l’arme qui déclenche la frappe, et non l’utilisateur.

L’exercice de la force échappe au jugement humain et il devient d’autant plus difficile de le maîtriser (photo CICR)

L’utilisation de systèmes d’armes autonomes présente des risques compte tenu de la difficulté à prévoir et à limiter leurs effets. Cette perte de contrôle et de jugement humain sur l’usage de la force et des armes soulève de graves préoccupations d’un point de vue humanitaire, juridique et éthique.

Mais le danger le plus palpable de l’intelligence artificielle concerne sans doute les armes létales autonomes. Généralement, il est question de drones ou de chars qui peuvent identifier des cibles et lancer une attaque sans aucune intervention humaine. Les armées des plus grands pays s’orientent de plus en plus dans le développement de ces armes alimentées par l’IA.

Cependant, tout logiciel peut connaître un dysfonctionnement. Maintenant, lorsqu’il est question de dispositifs militaires conçus pour tuer, cela pourrait être catastrophique. Et ce n’est pas qu’une appréhension, c’est déjà arrivé. En 2020, lors d’une guerre civile en Libye, un drone autonome aurait accidentellement tué un civil, selon un rapport de l’ONU. Pour certains experts et scientifiques, les armes autonomes seraient même plus dangereuses que les armes nucléaires.

Peut-on encore se protéger du danger de l’intelligence artificielle ?

Plus l’intelligence artificielle devient sophistiquée et performante, plus le danger qu’elle représente s’agrandit. Et cela peut nous affecter tous sans exception, voire mettre notre vie en péril. Cela voudrait dire que nous devrions nous méfier de cette technologie car ses désavantages nous propulseront forcément dans un monde hors de notre contrôle au vu de la rapidité de son développement et de l’avidité de ses concepteurs.

On n’a surtout pas pris le temps pour évaluer ses risques avant de la déployer à grande échelle. De toute manière, ces dangers ne pourraient jamais être évitées même avec un développement éthique et responsable de l’IA. Le problème fondamental est que l’approche a été centré sur les avantages technologiques et économiques et non sur l’humain. De plus, on n’a pas développé en même temps des garde-fous le protégeant.

Plus grave, à aucun moment on a pris le temps pour définir les limites de l’utilisation des systèmes intelligents et on peine à imposer des réglementations plus strictes. Malgré les initiatives comme le RGPD (règlement général sur la protection des données) ou l’AI Act, la course en avant frénétique et sans anticipation continue de plus belle.

Nous sommes directement menacées par une intelligence surhumaine et nous sommes exposés à un risque non négligeable car dans son développement, l’intelligence artificielle est conçue pour être autonome et la supervision humaine reste trop minime pour éviter tout incident pouvant entraîner des conséquences désastreuses.

Quelles menaces représentent les bots malveillants ?

En termes de cybersécurité, les attaques de bots malveillants et des autres cyberattaques préoccupent de plus en plus les utilisateurs car ils peuvent causer d’importants dommages. Un bot malveillant ou «bad bot» est un programme automatisé programmé pour lancer une attaque informatique. Les bots malveillants sont utilisés pour différents types d’attaques, dont certains sont justifiés pour dénoncer un comportement grave ou une atteinte personnelle. En termes simples, ces attaques servent à outrepasser les mesures de sécurité mises en place par les sites web.

Les attaques de bots malveillants

Ces attaques sont en augmentation et ce qui les rend importants est le fait qu’ils se répandent très rapidement. Par ailleurs, une des conséquences les plus graves est la publication d’informations privées sur une plateforme publique, appelée doxxing. Autrement dit, les bots soutirent des informations sur les sites pour les utiliser à des fins malveillantes.

Généralement, ils ont pour objectif d’obtenir un avantage commercial sur les concurrents. Pour les détaillants, une attaque de bots malveillants peut coûter plus de 162 millions de dollars. Les attaques peuvent se présenter sous forme de vol d’identité ou des coordonnées bancaires.

Qu’est-ce que le doxxing et pourquoi est-il difficilement puni par la loi ?

Le doxxing, c’est-à-dire la divulgation de données personnelles d’un internaute dans le but de lui nuire, est désormais clairement défini et puni par la loi. L’IA permet à tout et chacun de facilement fabriquer un «dox» et de le divulguer sur une grand échelle.

Le terme doxxing (ou doxing) fait partie de l’ensemble plus large du cyberharcèlement. Il a été popularisé et correspond au fait de «divulguer les données personnelles d’un individu dans le but de lui nuire ou de dénoncer un comportement inacceptable. Pratique très courante sur Internet, elle est initiée par une personne ou un groupe de personnes en colère qui se focalisent en général sur une personne – parfois sur plusieurs –, et travaillent de concert pour trouver et révéler des informations telles que le nom, l’adresse, ou l’employeur du ou des concernés.

Les raisons sont variées : il peut s’agir d’une vengeance personnelle, d’un raid numérique pour des divergences d’opinions, ou d’exemples plus "légitimes", comme dénoncer la maltraitance d’animaux, la pédophilie, le sexisme, etc. La mécanique est toutefois souvent la même : convoquer une communauté d’utilisateurs qui pratiquent un harcèlement ciblé sur la personne. Mais au nom de raisons moralement "supérieures", ces internautes se sont donnés le rôle de se faire justice eux-mêmes.

Matthieu Audibert, officier de gendarmerie et spécialiste de la cybercriminalité, expliquait que «au niveau juridique, le doxxing stricto sensu n’est pas défini dans le Code pénal et n’est donc pas réprimé en tant que tel (...) même s’il peut relever, selon les modes opératoires employés, de plusieurs infractions pénales.»

Les risques créés par l’IA générative

En matière d’intelligence artificielle, de nombreux risques doivent être pris en compte. L’un des plus grands risques est la possibilité d’une IA générative. Dans ce cas, l’IA crée d’elle-même de nouveaux contenus, sans intervention humaine, basés sur les probabilités qu’une information soit correcte ou fausse. L’IA générative est de plus en plus utilisée sur les réseaux sociaux, en marketing, et pourrait même être utilisée en journalisme.

Il y a quelques raisons majeures pour lesquelles cela pourrait être dangereux. Premièrement, cela pourrait créer un contenu inexact ou trompeur car basé sur des données existantes, y compris des fake news. Sans intervention humaine, cela pourrait accentuer la propagation de fausses informations par un effet domino et amener les utilisateurs à prendre de mauvaises décisions en fonction de ce qu’ils croient être vrai. Deuxièmement, cela pourrait créer un contenu offensant ou préjudiciable. Il pourrait en particulier s’agir de remarques racistes ou sexistes, de discours de haine ou de fausses nouvelles. Enfin, cela pourrait simplement créer un charabia difficile à interpréter pour les humains.

Réglementer permettrait-il de réduire les risques ?

De nombreux experts se sont inquiétés des risques posés par l’IA. Certains de ces risques sont liés à la technologie elle-même, tandis que d’autres sont associés à ses applications ou aux outils d’apprentissage automatique. Beaucoup de ces risques sont liées au fait que les outils d’intelligence artificielle sont aujourd’hui «étroits»: ils sont capables d’exécuter ou d’optimiser une tâche pour laquelle ils ont été entraînés mais n’ont aucune compréhension de ce qu’ils font ou du monde dans lequel ils évoluent – les chercheurs parlent souvent d’absence de «sens commun».

Un autre problème porte sur l’explicabilité: à la différence des logiciels classiques, les outils de l’IA évoluent à partir des données sur lesquelles on les entraîne, ce qui rend leurs décisions plus opaques car ces données contiennent des biais propres aux hommes qui les nourrissent.

L’un des principaux risques est que l’IA pourrait être utilisée pour créer des armes autonomes, également appelées «robots tueurs». Ces armes seraient capables de sélectionner et d’engager des cibles sans intervention humaine. Cela pourrait conduire à une nouvelle course aux armements et à une probabilité accrue de conflit.

Enfin, il existe le risque que l’IA devienne incontrôlable et constitue une menace pour l’humanité. À mesure que les systèmes d’IA deviennent plus sophistiqués, ils pourraient mieux cacher leurs activités aux humains et réaliser leurs objectifs à notre insu ou sans notre consentement.

En conclusion, l’IA est une technologie dominante en évolution rapide. Elle a un énorme potentiel pour transformer nos vies de façons multiples. Cependant, les avantages de l’IA s’accompagnent également de beaucoup de risques. Nous devons être conscients de ces risques et veiller à ne pas sacrifier la sécurité et notre humanité au profit de la facilité, de la simplicité, de l’efficacité ou, plus grave, de la fascination que l’IA exerce sur nous.

Le problème est que ses désavantages risquent de devenir incontrôlables malgré toutes les réglementations et précautions que nous pouvons prendre et qu’à un certain moment, nous deviendrons réellement esclaves d’un IA qui aura toujours une longueur d’avance sur nous, étant donnée sa capacité de prévision, sa rapidité de réaction et son implication dans le devenir de notre société et même, au final, du monde. Pour atténuer ce risque, il est important de veiller à ce que tout développement ou utilisation de l’IA soit étroitement contrôlé et réglementé par des lois mais nous savons tous que le propre des lois est de se faire contourner ou alors interpréter selon les intérêts des puissants du moment.

Maîtrisée, l’IA est une formidable opportunité sociétale et économique; dévoyée, elle représenterait un grand danger. (Getty Images)

«Rien dans la biosphère ne résiste désormais à la puissance destructrice de l’humain qui s’est arrogé le droit de vie et de mort sur le reste de la création.»

Lire plus :

Le danger des intelligences ! - La Presse+ - Boucar Diouf

La course à l’IA n’est pas sans risque : quels sont les dangers ?

L’IA de demain : les pères fondateurs poussent un cri d’alarme !

Pourquoi l’intelligence artificielle - peut présenter des risques - Les Echos

VIDEO. IA : et si les machines se programmaient seules ?

«Les machines ne savent pas gérer les situations imprévues»

Gary Marcus, professeur à New York University

Paru dans Le Courrier du lundi 31 juillet 2023

Les femmes, principales victimes des "deepfakes" fait par IA

Médias X

Entre applications photo graphiques qui déshabillent numériquement les femmes, messages sexualisés mettant en scène des filles nées de l’intelligence artificielle et images manipulées en vue d’un racket de «sextorsion», l’hypertrucage (deepfake) pornographique est en plein essor. Les législateurs se retrouvent pris de court.

La propagation de ces contenus altérés par l’intelligence artificielle (IA) a dépassé les efforts américains et européens visant à réglementer ce jeune domaine technologique.

Plusieurs photographies, fausses et perfectionnées, sont devenues virales ces derniers mois. L’une, prêtant à sourire, montrait le pape François en «doudoune», une énorme veste blanche rembourrée de duvet. L’autre, plus sérieuse, avait soi-disant immortalisé une arrestation de l’ancien président des Etats-Unis Donald Trump. Mais bien plus répandue est l’utilisation de ces algorithmes pour générer des contenus pornographiques, à l’insu des intéressés ciblés, dont les vies en sont parfois détruites, estiment des experts. Et les femmes en sont les premières victimes.

«L’essor de la pornographie généré par l’IA normalise l’utilisation de l’image ou de la ressemblance d’une femme sans son consentement», souligne auprès de l’AFP Sophie Maddocks,chercheuse à l’université de Pennsylvanie qui suit les abus sexuels liés à l’image. «En tant que société, quel message envoyons-nous sur le consentement lorsque vous pouvez virtuellement déshabiller n’importe quelle femme?» interroge-t-elle.

Ces hypertrucages ou «faux en profondeur» peuvent en effet ruiner une réputation, servir à des actes d’intimidation ou de harcèlement. Ils illustrent la menace de la désinformation par l’IA.

Selon une étude réalisée en 2019 par la société néerlandaise Sensity, spécialisée dans l’IA, 96% des fausses vidéos en ligne sont de la pornographie non consensuelle. La plupart d’entre elles représentent des femmes: des célébrités comme la chanteuse Taylor Swift et l’actrice Emma Watson, mais aussi énormément de femmes qui n’occupent pas le premier plan médiatique.

Les médias américains et européens regorgent de témoignages de femmes universitaires ou militantes qui ont été choquées de découvrir leur visage dans du «deepfake» pornographique. «Le fantasme sexuel, très privé, développé autrefois dans l’imaginaire d’une personne, est maintenant transféré à la technologie et aux créateurs de contenu dans le monde réel», résume pour l’AFP Roberta Duffield, directrice de l’intelligence chez Blackbird.AI.

Le mois dernier, le FBI a mis en garde contre les chantages aux hypertrucages sexuels, fabriqués à partir d’images diffusées sur les réseaux sociaux et utilisés pour extorquer de l’argent aux victimes ou à leur famille, ces victimes pouvant être des enfants.

Face à cette prolifération d’outils d’IA, la réglementation est dépassée. «La loi doit rattraper son retard», professe Dan Purcell, directeur général et fondateur de la société Ceartas, spécialisée dans la protection des marques. «Il ne s’agit pas d’un coin sombre de l’Internet, où ces images sont créées et partagées. C’est juste sous notre nez», dit-il à l’AFP, en prônant des lois internationales harmonisées. «L’Internet est une juridiction sans frontières.»

ANUJ CHOPRA ATS/AFP

Liens :

* * *

|

Note du compilateur : G.P.T.

Ci-dessous, un typique exemple de comment convaincre les gens d’adhérer à l’IA toute en passant chat sur braises sur les problèmes qu’elle pose et de n’apporter autre réponse que celle de la "bonne foi" des hommes tout en admettant qu’il y en a de bien "tordus" qui profiteront à fond du système et de ses hardwares. Elle fait aussi une confiance aveugle aux réglementations censées "prévenir" les abus...

Le plus significatif étant que malgré le fait que derrière ses lignes pointe une inquiétude palbale, Sabine Süsstrunk, professeure à l’EPFL, insiste sur les "bienfaits" du ChatGPT et les lois (faites par les mêmes hommes qui les ont créé) pour ne pas perdre les intérêts qu’elle a de propager ce système selon elle certes imparfait mais terriblement rentable à la longue...

Lisez donc pour vous faire une opinion...

|

Magazine Coopération du 31 juillet 2023

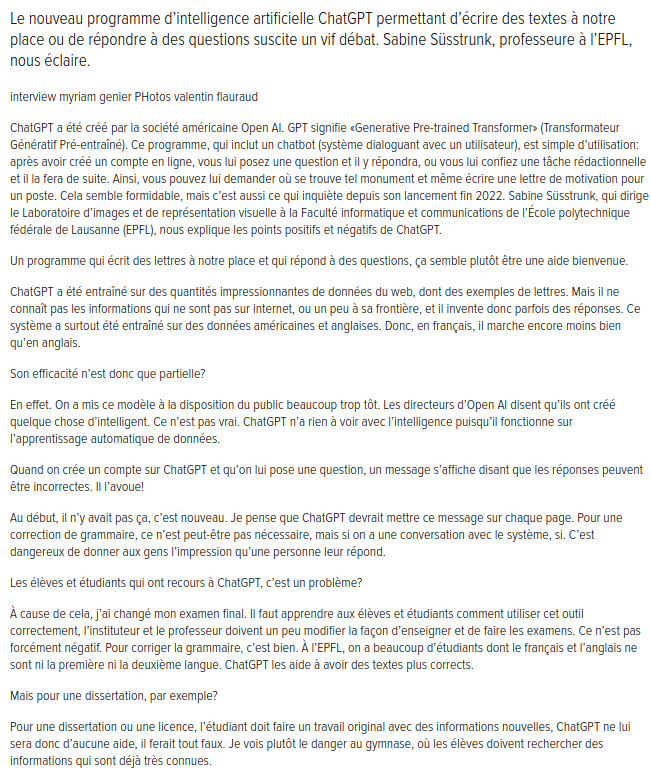

Doit-on avoir peur du ChatGPT ?

«C’est l’humain qui fait le bien ou le mal, pas un système ou un hardware.»

Sabine Süsstrunk, professeure à l’EPFL

Paraphrase personnelle du compilateur :

«C’est l’humain qui profite de faire le mal avec l’aide d’un système ou d’un hardware conçu pour cela par d’autres hommes.»

G.P.T., compilateur

Commentaires et conclusions perso

|

Le temps est venu pour tempérer en quelle que sorte cet engouement et sidération malsaine pour cette technologie qui nous dépasse, le pire étant que celle-ci est entre les mains de seuls quelques manitous car pour le commun des gens, elle est complètement hors de notre portée. Pour nous consoler, nous n’avons accès qu’à sa version grand-publique (ChatGPT) où cela est devenue carrément un jeu dont les conséquences ne sont pas mesurables.

Certes l’IA pourrait nous apporter des progrès formidables et fulgurants (et c’est justement là le problème) en médecine ou ailleurs mais cela ne compensera pas, et de loin, les usages autres qui seront possibles surtout entre les mains de ces quels qu’uns qui n’y voient que leurs intérêts et profits personnels et tout cela au détriment du reste de la société.

Que mes compilations, écrites sur la base d’articles concernant l’IA, soient l’avertissement nécessaire pour une réflexion solide non pas pour bannir ou interdire l’IA mais pour y mettre des cautèles telles que tout développement qui peut se retourner contre le peuple – ou être à son détriment – soit impossible ou, du moins, condamnable.

Malheureusement, en consultant la loi que l’EU propose (Loi sur l’IA de l’UE), nous en sommes loin – même très loin – de ces cautèles car trop d’intérêts économiques et politiques sont en jeux et cela pour notre plus grand malheur.

Nous devons lancer un cri d’alarme et inciter les gens à une réflexion sur notre devenir face à la technologie actuellement hors de portée du simple quidam. Que des publications telles que «L’Essor» ou tout autre magazine alternatif tel «solidaritéS» soient l’alarme qui résonne dans l’espoir que cela provoquera une remise en question de ce "progrès" qui deviendra sinon vite "infâme"...!!!

Note du compilateur G.P.T.Pully, le 24 juillet 2023

|

* * *

@quantumlife8426

Autres lettres d’auditeurs

Les plus gros risques lors de l’utilisation de tels outils

Fuite de vos données personnelles ou recherches.

Possible désinformation à cause des biais de l’IA liés à l’éthique ou autre contrôles internes.

Faire face à des messages types correspondant à une réponse basique et incomplète qui ne traite pas correctement le sujet ou la question posée.

Biais d’orientation politiques de l’outil sur certaines questions pouvant fausser la réponse ou transmettre indirectement une idéologie sous-jacente.

Rendre fainéant les humains, puisqu’ils n’iront pas ou plus chercher l’information par eux-mêmes dans les livres, bibliothèques, articles scientifiques, etc...

Même si les réponses sont sourcées, il faudra toujours vérifier et fact-checker la sincérité, la cohérence et la fiabilité des informations fournies.

Risque que les humains ne pensent ou ne réfléchissent plus par eux-mêmes, laissant ainsi l’IA devenir leur maître à penser (pensée unique/unidirectionnelle/conformiste).

Le nombre limité de caractères, les limites dans les capacités de l’IA à produire des liens complexes entre des sujets divers et variés qui ne vous serait pas venu directement à l’esprit.

La fonction d’auto-jugement des utilisateurs en fonction des réponses fournies aux questions (bonne ou mauvaise) pouvant altérer/modifier les résultats en fonction des likes/dislikes.

Le fait de croire qu’il n’existe qu’une seule et unique réponse à une question, alors qu’il y en a plusieurs.

Le possible argument d’autorité de l’IA.

L’externalisation de l’information va aussi réduire les capacités mémorielles des humains, on travaille et on retient mieux sur papier que sur PC.

Ne plus faire fonctionner sa créativité ou son imagination et laisser faire l’IA à notre place (perte de capacité créatives sur le long terme).

Voilà en tout cas c’est ceux qui me viennent à l’esprit mais il y en a certainement d’autres.

Pour plus d’informations sur le sujet, regardez la vidéo de Sebastien Bubeck Sparks of AGI: early experiments with GPT-4.

«Une humanité qui voudrait trop s’en remettre aux machines et à l’intelligence artificielle pourrait courir à sa perte.»

Stephen Hawking - astrophysicien

Lire et écouter plus :

Compilation personnelle

L’économie numérique transforme le monde - L’Essor Forum juillet 2018

The Malicious Use of Artificial Intelligence : Future of Humanity Institute, feb. 2018

Et si l’intelligence artificielle était déjà hors de contrôle ? - Le Temps, 09 Janvier 2018

L’IA favorise la standardisation et non la diversité - PME Management & Mercato, 15 mars 2023

Comment positiver l’IA - compilation pour/contre

Troquer la démocratie contre les apps - et l’IA - LE COURRIER, 6 Mars 2023

Les Dangers de l’IA Compilation d’article concernant l’IA - G.P.T.

L’IA au scalpel - une technologie omniprésente - PME Magazine, 19 avril 2022

ChatGPT débarque sur le campus - 24heures - 03 mai 2023

Compilation d’articles - concernant l’IA par G.P.Taf, mars 2023

L’environnement social et humain - dans lequel on veut implanter l’IA par G.P.Taf, juil. 2023

Tout ce que vous voulez savoir - sur l’IA par G.P.Taf. - juin 2023

Créer l’intelligence elle-même - résumé de tous les clichés concernant l’IA - AFP, 20.03.2023

Faut-il vraiment craindre l’Intelligence Artificielle ? - alors que les risques sont réels - 24heures - 30 mars 2023

Les machines n’ont pas d’intelligence - Mais elles en auront - 24heures, 15 avril 2023

L’intelligence artificielle est déjà omniprésente - dans nos vies - Le Temps - 8 janvier 2018

Une technologie qui se met en garde - contre elle-même - PME Magazime, 28.04.2023

ChatGPT débarque sur le campus - La déferlante de l’IA - 24heures, 03 mai 2023

Les machines n’ont pas d’intelligence - Mais elles en auront - 24heures, 15 avril 2023

Le deepfake pornographique - aux dépens des femmes - 24heures, 25.07.2023

De l’utilisation de l’IA - au quotidien - Le Temps et swiss-info

Une critique pertinente - de l’IA médiatique - Le Courrier du 07.08.2023 et "Moins!"

Qui est derrière - la folie l’IA ? - Le Courrier du lundi 28 aoôt 2023

Quel futur l’IA nous réserve-t-elle ?

L’IA et la Guerre le point de vue des militaires

Georges Tafelmacher - son site

compilation par Georges Tafelmacher (G.P.T.)

dans son site : Ché Tafel - TAFELMACHER-GEORGES.COM

- l’âme des robots -

DATE DE CRÉATION : 28.07.2023 - DERNIÈRE MODIFICATION : 11.08.2023

par: Georges Tafelmacher Copyleft © 2023 TAFELMACHER-GEORGES.COM

All Rights to serve.